Arquivo Robots.txt: o que é e como otimizá-lo para SEO

O arquivo robots.txt é implementado em seu site WordPress para sinalizar aos mecanismos de pesquisa que rastreiem os URLs, arquivos e tipos que você deseja. Quer você seja um usuário iniciante ou experiente do WordPress, compreender a finalidade e o uso adequado do arquivo robots.txt é crucial.

Se você puder informar ao Google ou a outros mecanismos de pesquisa qual conteúdo rastrear, isso poderá acelerar a indexação do seu conteúdo mais relevante.

Neste guia, aprenderemos principalmente sobre:

👉 O que é o arquivo robots.txt no WordPress?

👉 Como criar arquivo robots.txt no WordPress?

👉 Como otimizar o arquivo robots.txt no WordPress?

👉 Como testar o arquivo robots.txt?

Assim, você pode melhorar o rastreamento e a indexação do seu site WordPress.

O que é um arquivo Robots.txt?

Adicionar um arquivo Robots.txt ao diretório raiz do site WordPress é uma prática comum de SEO que instrui os mecanismos de pesquisa em quais páginas rastrear e quais ignorar. Em geral, os navegadores da web pesquisam todas as páginas do seu site disponíveis publicamente em um processo conhecido como rastreamento.

Quando você coloca um arquivo robots.txt no diretório raiz do seu site WordPress, os mecanismos de pesquisa procuram todos os URLs especificados nele para determinar quais rastrear. Aqui, uma coisa deve ficar clara: o arquivo robots.txt não é usado para fins de índice ou não-índice. Em vez disso, o arquivo robots.txt está apenas ajudando os bots dos mecanismos de pesquisa a rastrear suas páginas da web.

Qual é a aparência do Robots.txt?

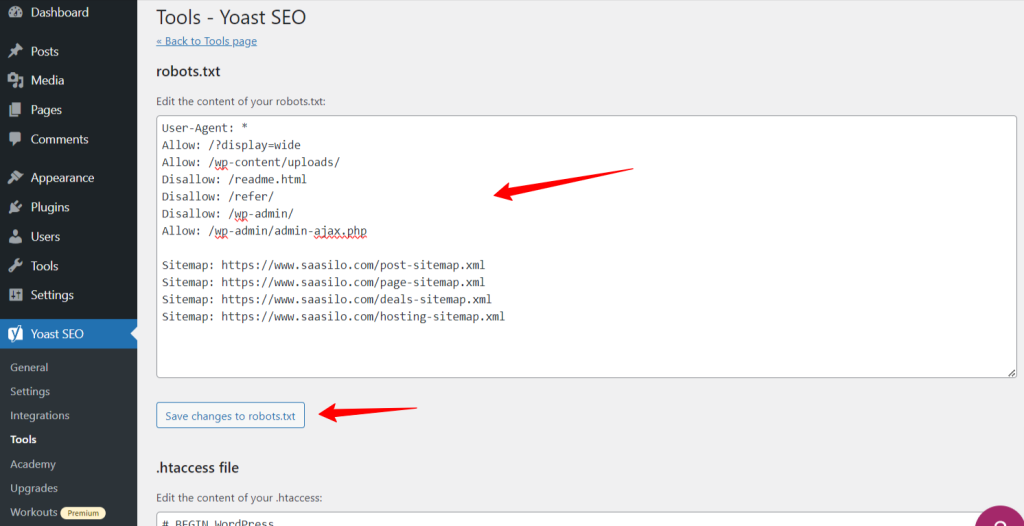

Queremos ver como fica, pois já aprendemos sobre o arquivo Robots.txt. É um arquivo de texto simples, não importa o tamanho do site. A maioria dos proprietários de sites define algumas regras com base em seus requisitos.

Aqui está um exemplo de arquivo robots.txt:

Permitir: /?display=wide

Permitir: /wp-content/uploads/

Não permitir: /readme.html

Proibir: /referir/

Proibir: /wp-admin/

Permitir: /wp-admin/admin-ajax.php

Mapa do site: https://www.saasilo.com/post-sitemap.xml

Mapa do site: https://www.saasilo.com/page-sitemap.xml

Mapa do site: https://www.saasilo.com/deals-sitemap.xml

Mapa do site: https://www.saasilo.com/hosting-sitemap.xml

No arquivo robots.txt acima, várias regras determinam quais URLs e rastreadores de arquivos têm permissão ou não de acesso no site.

Aqui está o detalhamento deste arquivo robots.txt:

Agente de usuário: aplica as regras a seguir a todos os rastreadores da Web.

Permitir: /?display=wide: permite que os rastreadores acessem URLs com ?display=wide na string de consulta.

Permitir: /wp-content/uploads/: Incentive os bots dos mecanismos de pesquisa a rastrear todos os arquivos e diretórios em /wp-content/uploads/.

Permitir: /wp-admin/admin-ajax.php: permite que os rastreadores acessem o arquivo admin-ajax.php dentro do diretório /wp-admin/.

Não permitir: /readme.html: impede que rastreadores acessem o arquivo readme.html.

Proibir: /referir/: impede que crawlers acessem o diretório /refer/ e todo o seu conteúdo.

Proibir: /wp-admin/: evita que rastreadores acessem o diretório /wp-admin/ e seu conteúdo.

Permitir: /wp-admin/admin-ajax.php: permite que os rastreadores acessem o arquivo admin-ajax.php dentro do diretório /wp-admin/.

Mapa do site: por último, todos os URLs vinculados ao mapa do site estão disponíveis para rastreamento por bots de pesquisa.

Você precisa de um arquivo Robots.txt para o seu site WordPress?

Agora aprenderemos a importância de um arquivo robots.txt bem configurado para nosso site WordPress. Aqui estão algumas funções importantes do arquivo robots.txt para gerenciar e otimizar o desempenho e a visibilidade do seu site.

➡️ Controle sobre rastreamento: os bots dos mecanismos de pesquisa são inteligentes o suficiente para descobrir todas as páginas ou conteúdos públicos do seu site. Porém, queremos manter algumas páginas privadas, pois elas contêm arquivos administrativos, como páginas de plug-ins ou arquivos de sistema do seu site WordPress. E usar o arquivo robots.txt ajudará você a evitar o rastreamento dessas páginas irrelevantes.

➡️ Indexação mais rápida para SEO: Como já dissemos, o arquivo robots.txt não facilita diretamente a indexação de suas páginas web. No entanto, o arquivo robots.txt ainda pode acelerar o processo de indexação. Isso acontece porque você remove páginas desnecessárias e irrelevantes do rastreamento.

➡️ Precisa de menos largura de banda: os bots dos mecanismos de pesquisa não precisam navegar por todo o seu site quando você lhes dá instruções sobre quais áreas precisam ser rastreadas. Isso diminuirá o uso de recursos do servidor e largura de banda. O que também melhora o desempenho geral do seu site.

➡️ Nenhum problema de conteúdo duplicado: Um erro comum indesejado dos proprietários de sites é publicar conteúdo duplicado. Isso ilude bots de mecanismos de pesquisa sobre qual conteúdo deve ser indexado ou não. Ou serão mal compreendidos e o conteúdo original poderá receber uma classificação inferior ou ser punido. Adicionar um arquivo robots.txt pode garantir que não haverá indexação de várias versões do mesmo conteúdo.

➡️ Evite bots e rastreadores inseguros: Você pode restringir facilmente qualquer rastreador de spam ou bot de pesquisa em um arquivo robots.txt. Isso aumentará a segurança do seu site WordPress. Além disso, você também pode impedir o rastreamento das páginas de administração.

Como criar um arquivo Robots.txt no WordPress?

Agora que entendemos a importância de adicionar um arquivo robots.txt ao nosso site WordPress, o próximo passo é aprender como criar um. Com isso em mente, mostraremos dois métodos de como criar um arquivo robots.txt em seu site WordPress.

Método 1: criar um arquivo Robots.txt usando o plug-in

A maneira mais fácil de criar e editar o arquivo robots.txt é usando um plugin. Vá para o painel do WordPress e siga Plug-ins > Adicionar novo. Agora, instale e ative um plugin de SEO como Yoast SEO ou Classificação matemática.

Vamos ver o caminho deles:

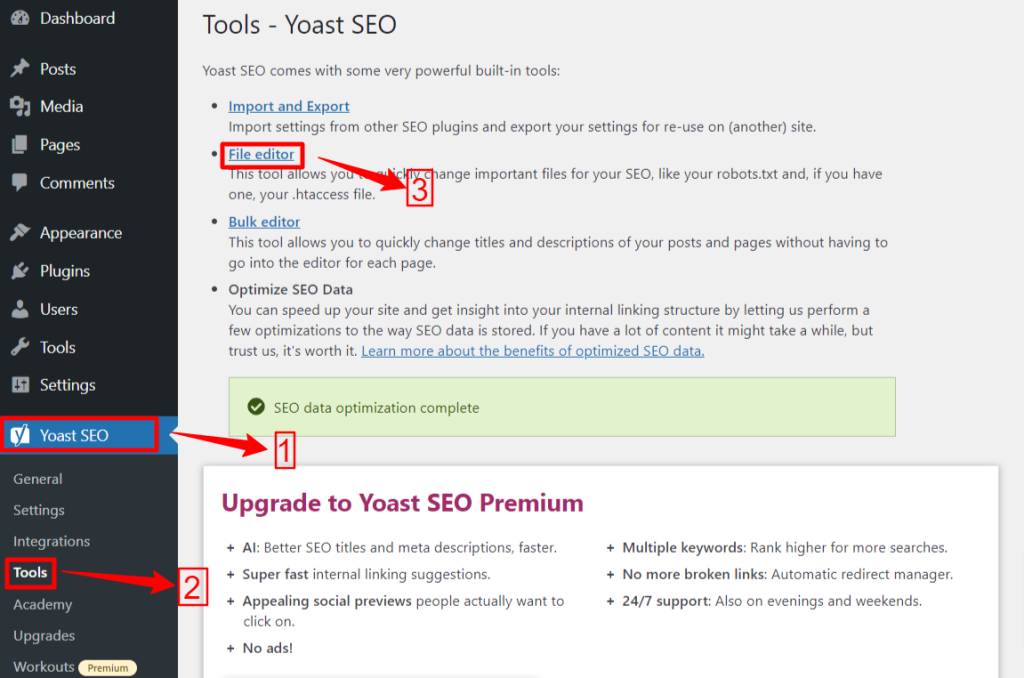

🟢 Yoast SEO:

Se você estiver usando Yoast SEO, na área de administração do WP navegue até o Yoast SEO > Ferramentas e clique Editor de arquivos, e então "Crie o arquivo Robots.txt” se você não tiver nenhum arquivo robots.txt. Em seguida, você irá para a tela do editor.

Após editar ou alterar seu arquivo robots.txt, clique em “Salvar alterações em robots.txt”. É isso.

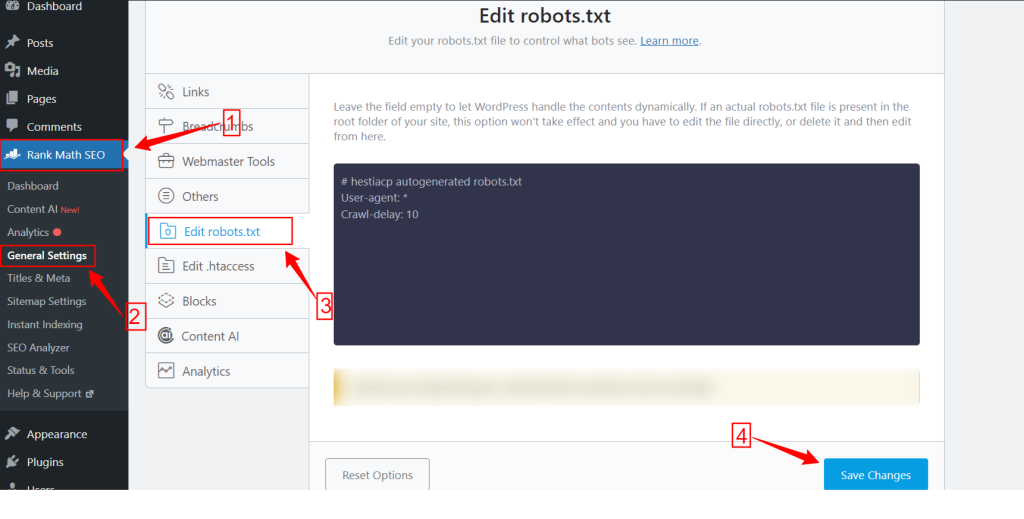

🟢 Classificação matemática:

Ao usar o plugin Rank Math, vá para o painel Rank Math no painel do WordPress e clique em Configurações Gerais. Em seguida, selecione o Editar robots.txt aba. Faça suas alterações e edite na tela do robots.txt e clique no botão Salvar alterações botão quando terminar.

Observação: Você precisa excluir o arquivo robots.txt padrão da pasta raiz do site usando o cliente FTP.

Método 2: criar arquivo Robots.txt manualmente usando FTP

O processo manual de adição de um arquivo robots.txt requer que você acesse a hospedagem WordPress usando um cliente FTP como FileZilla, WinSCP e Cyberduck. As informações de login do FTP estão disponíveis no cPanel.

Como você sabe, o arquivo robots.txt precisa ser carregado na pasta raiz do site, portanto você não pode colocá-lo em nenhum subdiretório.

Você também pode criar um arquivo robots.txt no cliente FTP, se não houver nenhum. No seu computador local, abra um editor de texto simples como o Bloco de Notas e insira as diretivas abaixo:

Proibir: /wp-admin/

Permitir: /wp-admin/admin-ajax.php

Salve este arquivo como robots.txt. Agora, dentro do cliente FTP, procure o “Upload de arquivo”E carregue o arquivo robots.txt para a pasta raiz do site.

Agora, para abrir o arquivo robots.txt recém-criado ou anterior, clique com o botão direito nele e selecione “Editar”Opção. Faça suas alterações e edite, depois clique no botão Salvar opção. Agora, verifique seu arquivo robots.txt adicionando o arquivo robots.txt após seu nome de domínio. Como seudomínio.com/robots.txt.

Como otimizar seu robots.txt WordPress para SEO

Agora que sabemos como criar e editar um arquivo robots.txt em um site WordPress, vamos nos concentrar nas práticas recomendadas para otimizar o arquivo robots.txt para o seu site WordPress.

✅ Crie um arquivo conciso

Adicionar um arquivo robots.txt simples ajuda os bots do rastreador a entender suas diretivas facilmente, para que consumam menos recursos. Além disso, você pode evitar riscos indesejados decorrentes de conflitos ou erros.

✅ Excluir diretórios e arquivos WP

Não devemos permitir que determinados arquivos e diretórios sejam rastreados pelos bots de busca, pois essas áreas contêm informações essenciais e confidenciais. Quando você exclui esses links do arquivo robots.txt, os bots de pesquisa não visitarão essas áreas do seu site. Portanto, você pode garantir o uso ideal dos recursos de rastreamento.

Vamos conhecer alguns dos diretórios e arquivos do WP:

/wp-admin/ e /wp-inclui/: Esses diretórios podem dar acesso à área de administração e aos arquivos principais que fazem todo o site WordPress funcionar, o que pode ser uma ameaça à segurança. Se os bots de busca rastrearem essas áreas, isso poderá ser uma ameaça crucial à segurança. Então, temos que ativar as diretivas Disallow.

Proibir: /wp-includes/

Página de login: Outra medida de segurança importante é desindexar a página de login. Para parar de rastrear:

leia-me.html: A página leia-me pode revelar informações cruciais, como a versão atual do WordPress do seu site, para possíveis hackers. Portanto, considere desindexá-lo também.

Páginas de tags e categorias: essas páginas desperdiçam orçamentos de rastreamento devido à sua irrelevância para as consultas de pesquisa e confundem os mecanismos de pesquisa com conteúdo duplicado.

Proibir: /categoria/

Procurar Resultados: o motivo acima também se aplica às páginas internas de resultados de pesquisa.

Links de referência: Os programas de afiliados produzem links de referência que também não precisam ser rastreados.

✅ Inserir link do mapa do site

Geralmente, os usuários do WordPress enviam seu mapa do site para as contas do Google Search Console ou das Ferramentas do Google para webmasters para rastrear dados analíticos e de desempenho. No entanto, adicionar um mapa do site ao arquivo robots.txt pode ajudar os rastreadores a descobrir o conteúdo do seu site.

O Sitemap ajudará a indexar o seu site com mais rapidez, pois os mecanismos de pesquisa podem navegar facilmente pela estrutura e hierarquia do seu site. Você pode definir as páginas que deseja priorizar para rastreamento. Outra coisa boa é que um mapa do site pode orientar os rastreadores sobre as atualizações mais recentes do seu site.

✅ Uso Eficaz de Curingas

Os curingas são sua arma eficaz para definir regras baseadas em padrões que permitem que os mecanismos de pesquisa bloqueiem ou acessem um grupo de URLs ou tipos de arquivos específicos. Dessa forma, você não precisa restringir várias páginas separadamente, consumindo muito tempo.

Curingas são caracteres especializados como Asterisco (*) e Cifrão ($). Vamos descrevê-los:

Asterisco (*): O curinga mais comum é o Asterisco (*), que aplica regras amplamente para um grupo ou URLs ou tipos de arquivo com correspondência de padrão específico.

O código acima não permite que qualquer mecanismo de pesquisa rastreie qualquer parte do site.

Cifrão ($): Isso indica o fim do URL, então você pode permitir ou bloquear qualquer URL que inclua um termo específico como “pdf”.

Não permitir: /*.jpg$

Não permitir: /*.docx$

Você pode ser mais estratégico usando curingas. Tipo, você pode bloquear ou permitir:

Diretórios específicos: Bloqueará quaisquer URLs que comecem com /private/, incluindo quaisquer arquivos ou subdiretórios dentro dele.

Proibir: /privado/

URLs com parâmetros específicos: Bloqueará todos os URLs que contenham a classificação do parâmetro de consulta, como /category/?pdf=asc.

Não permitir: /*.pdf$

Padrões específicos: Bloqueará todos os URLs que incluam a palavra “checkout”, como /produto/checkout ou /carrinho/checkout.

Proibir: /*checkout

Permitindo arquivos ou diretórios específicos em diretórios bloqueados: Bloqueará todos os URLs em /wp-admin/ exceto admin-ajax.php

Proibir: /wp-admin/

Permitir: /wp-admin/admin-ajax.php

✅ Usar comentários

Para melhorar a legibilidade e a clareza do seu arquivo robots.txt, você pode adicionar comentários. Isso é feito usando um sinal de hash (#) no início da linha que você deseja adicionar como comentário.

✅ Monitore o comportamento de rastreamento

Verifique se há algum problema de rastreamento e indexação após enviar o arquivo robots.txt usando ferramentas de mecanismo de pesquisa como Google Search Console ou Ferramentas do Google para webmasters.

✅ Especifique regras para bots de pesquisa

Alguns especialistas também afirmaram que uma estratégia eficaz é criar regras diferentes para diferentes bots de mecanismos de pesquisa em arquivos robots.txt. Especificar como cada bot acessará e rastreará seu site ajudará você a construir seu estratégia de conteúdo e otimização desempenho.

✅ Considere versões móveis e AMP

Da mesma forma, você pode alterar e ajustar as diretivas do seu arquivo robots.txt para versões móveis e AMP.

✅ Atualize seu arquivo Robots.txt

Porém, criar um arquivo robots.txt é sua tarefa quando começar a construir seu site WordPress. No entanto, você deve procurar frequentemente por quaisquer alterações na estrutura do seu site e nas atualizações do algoritmo do mecanismo de pesquisa para poder atualizar o arquivo robots.txt.

✅ Não faça experiências

O arquivo robots.txt faz parte do diretório raiz do site WordPress. Portanto, você não deve fazer nenhum experimento com ele. Para qualquer confusão, peça ajuda especializada ou mantenha um arquivo robots.txt simples.

✅ Checagem final

Antes de enviar ou editar o arquivo robots.txt, você deve garantir que fez uma verificação final.

Como testar seu arquivo Robots.txt

Até este ponto, você aprendeu como editar e otimizar o arquivo robots.txt no seu site WordPress. No entanto, esse conhecimento não está completo sem entender como testá-lo. O teste é crucial para garantir que os bots dos mecanismos de pesquisa rastreiem seu site com precisão.

Um método principal é usar o ferramenta de teste robots.txt no Google Search Console. Esta ferramenta verifica se o Google está rastreando o seu site de acordo com as diretivas especificadas.

Agora, se o seu site estiver adicionado ao Google Search Console, faça login nele. Selecione seu site em “Selecione uma propriedade”. A ferramenta começará a buscar o arquivo robots.txt do seu site.

Após a verificação, a ferramenta de teste do robots.txt mencionará todos os erros e avisos de sintaxe. Então, você terá que corrigi-los e enviar o arquivo robots.txt novamente.

Embrulhar!

Compreender e otimizar seu arquivo robots.txt é uma parte crucial do SEO técnico e do gerenciamento eficaz do site. Esperamos este guia completo sobre como otimizar seu robots.txt WordPress para SEO.

Agora, você pode configurar facilmente quais partes do seu site devem ser rastreadas pelos mecanismos de pesquisa. No geral, você verá uma melhoria na eficiência de indexação e no desempenho geral do site.