Fichier Robots.txt : qu'est-ce que c'est et comment l'optimiser pour le référencement

Le fichier robots.txt est implémenté sur votre site Web WordPress pour signaler aux moteurs de recherche d'explorer les URL, les fichiers et les types souhaités. Que vous soyez un utilisateur débutant ou chevronné de WordPress, il est crucial de comprendre le but et la bonne utilisation du fichier robots.txt.

Si vous pouvez indiquer à Google ou à d’autres moteurs de recherche quel contenu explorer, cela peut accélérer l’indexation de votre contenu le plus pertinent.

Dans ce guide, nous apprendrons principalement :

👉 Qu'est-ce que le fichier robots.txt dans WordPress ?

👉 Comment créer un fichier robots.txt dans WordPress ?

👉 Comment optimiser le fichier robots.txt dans WordPress ?

👉 Comment tester le fichier robots.txt ?

Vous pouvez ainsi améliorer l’exploration et l’indexation de votre site Web WordPress.

Qu'est-ce qu'un fichier Robots.txt ?

L’ajout d’un fichier Robots.txt au répertoire racine du site Web WordPress est une pratique de référencement courante indiquant aux moteurs de recherche quelles pages explorer et lesquelles ignorer. En général, les navigateurs Web recherchent toutes les pages Web accessibles au public de votre site Web selon un processus appelé exploration.

Lorsque vous placez un fichier robots.txt dans le répertoire racine de votre site Web WordPress, les moteurs de recherche recherchent toutes les URL qui y sont spécifiées pour déterminer lesquelles explorer. Ici, une chose doit être claire : le fichier robots.txt n'est pas utilisé à des fins d'indexation ou non. Au lieu de cela, le fichier robots.txt aide uniquement les robots des moteurs de recherche à explorer vos pages Web.

À quoi ressemble le fichier Robots.txt ?

Nous voulons voir à quoi cela ressemble, comme nous l'avons déjà appris sur le fichier Robots.txt. Il s'agit d'un simple fichier texte, quelle que soit la taille d'un site Web. La plupart des propriétaires de sites Web établissent quelques règles en fonction de leurs besoins.

Voici un exemple de fichier robots.txt :

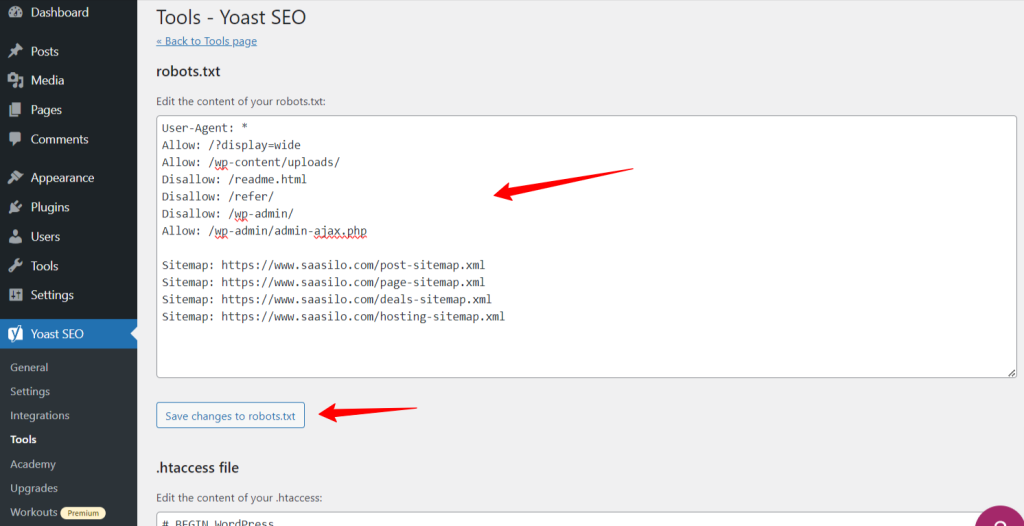

Autoriser : /?display=wide

Autoriser : /wp-content/uploads/

Interdire : /readme.html

Interdire : /référer/

Interdire : /wp-admin/

Autoriser : /wp-admin/admin-ajax.php

Plan du site : https://www.saasilo.com/post-sitemap.xml

Plan du site : https://www.saasilo.com/page-sitemap.xml

Plan du site : https://www.saasilo.com/deals-sitemap.xml

Plan du site : https://www.saasilo.com/hosting-sitemap.xml

Dans le fichier robots.txt ci-dessus, diverses règles dictent les URL et les robots d'exploration de fichiers dont l'accès est autorisé ou non au sein du site Web.

Voici la répartition de ce fichier robots.txt :

Agent utilisateur: applique les règles suivantes à tous les robots d'exploration Web.

Autoriser : /?display=wide: permet aux robots d'exploration d'accéder aux URL avec ?display=wide dans la chaîne de requête.

Autoriser : /wp-content/uploads/: Encouragez les robots des moteurs de recherche à explorer tous les fichiers et répertoires dans /wp-content/uploads/.

Autoriser : /wp-admin/admin-ajax.php: Permet aux robots d'exploration d'accéder au fichier admin-ajax.php dans le répertoire /wp-admin/.

Interdire : /readme.html: empêche les robots d'exploration d'accéder au fichier readme.html.

Interdire : /référer/: empêche les robots d'exploration d'accéder au répertoire /refer/ et à tout son contenu.

Interdire : /wp-admin/: Empêche les robots d'exploration d'accéder au répertoire /wp-admin/ et à son contenu.

Autoriser : /wp-admin/admin-ajax.php: Permet aux robots d'exploration d'accéder au fichier admin-ajax.php dans le répertoire /wp-admin/.

Plan du site: Enfin, toutes les URL liées au plan du site sont disponibles pour être explorées par les robots de recherche.

Avez-vous besoin d'un fichier Robots.txt pour votre site WordPress ?

Nous allons maintenant apprendre l'importance d'un fichier robots.txt bien configuré pour notre site Web WordPress. Voici quelques rôles importants du fichier robots.txt pour gérer et optimiser les performances et la visibilité de votre site.

➡️ Contrôle de l'exploration: Les robots des moteurs de recherche sont suffisamment intelligents pour identifier toutes les pages ou le contenu publics de votre site Web. Mais nous souhaitons garder certaines pages privées car elles contiennent des fichiers administratifs comme les pages du plugin ou les fichiers système de votre site WordPress. Et l’utilisation du fichier robots.txt vous aidera à empêcher l’exploration de ces pages non pertinentes.

➡️ Indexation plus rapide pour le référencement : Comme nous l'avons déjà dit, le fichier robots.txt ne facilite pas directement l'indexation de vos pages Web. Cependant, le fichier robots.txt peut toujours accélérer le processus d'indexation. Cela se produit parce que vous supprimez les pages inutiles et non pertinentes de l'exploration.

➡️ Besoin de moins de bande passante: Les robots des moteurs de recherche n'ont pas besoin de surfer sur votre site Web lorsque vous leur indiquez les zones à explorer. Cela réduira l’utilisation des ressources du serveur et de la bande passante. Ce qui améliore également les performances globales de votre site Web.

➡️ Aucun problème de contenu en double : Une erreur courante et indésirable des propriétaires de sites Web consiste à publier du contenu en double. Cela fait illusion les robots des moteurs de recherche indiquant quel contenu doit être indexé ou non. Ou alors, ils seront mal compris et le contenu original pourrait être moins bien classé ou puni. L'ajout d'un fichier robots.txt peut garantir qu'il n'y aura pas d'indexation de plusieurs versions du même contenu.

➡️ Évitez les robots et les robots d'exploration non sécurisés : Vous pouvez facilement restreindre les robots d'exploration spammés ou les robots de recherche dans un fichier robots.txt. Cela améliorera la sécurité de votre site Web WordPress. De plus, vous pouvez également interdire l’exploration des pages d’administration.

Comment créer un fichier Robots.txt dans WordPress ?

Maintenant que nous comprenons l’importance d’ajouter un fichier robots.txt à notre site WordPress, la prochaine étape consiste à apprendre à en créer un. Dans cet esprit, nous allons vous montrer deux méthodes pour créer un fichier robots.txt sur votre site Web WordPress.

Méthode 1 : créer un fichier Robots.txt à l'aide du plugin

Le moyen le plus simple de créer et de modifier le fichier robots.txt consiste à utiliser un plugin. Accédez à votre tableau de bord WordPress et suivez Plugins > Ajouter un nouveau. Maintenant, installez et activez un plugin SEO comme Yoast SEO ou Classer les mathématiques.

Voyons leur chemin :

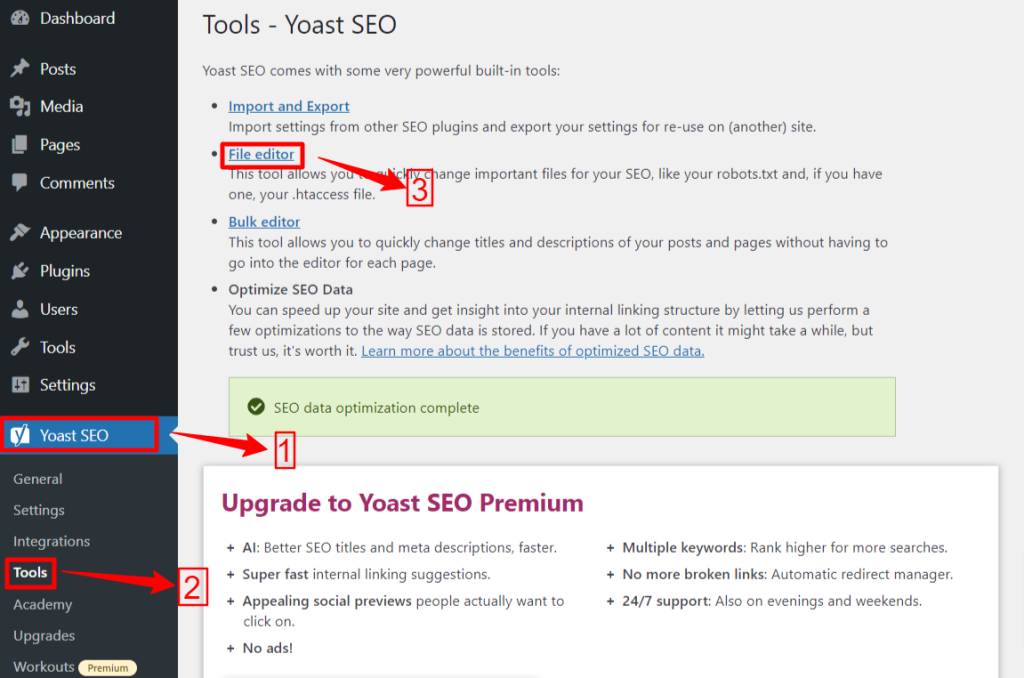

🟢 Yoast SEO :

Si vous utilisez Yoast SEO, depuis votre zone d'administration WP, accédez au Yoast SEO > Outils et cliquez Éditeur de fichiers, et puis "Créer un fichier Robots.txt » si vous n'avez pas de fichier robots.txt. Ensuite, vous passerez à l’écran de l’éditeur.

Après avoir modifié ou modifié votre fichier robots.txt, cliquez sur « Enregistrer les modifications dans robots.txt ». C'est ça.

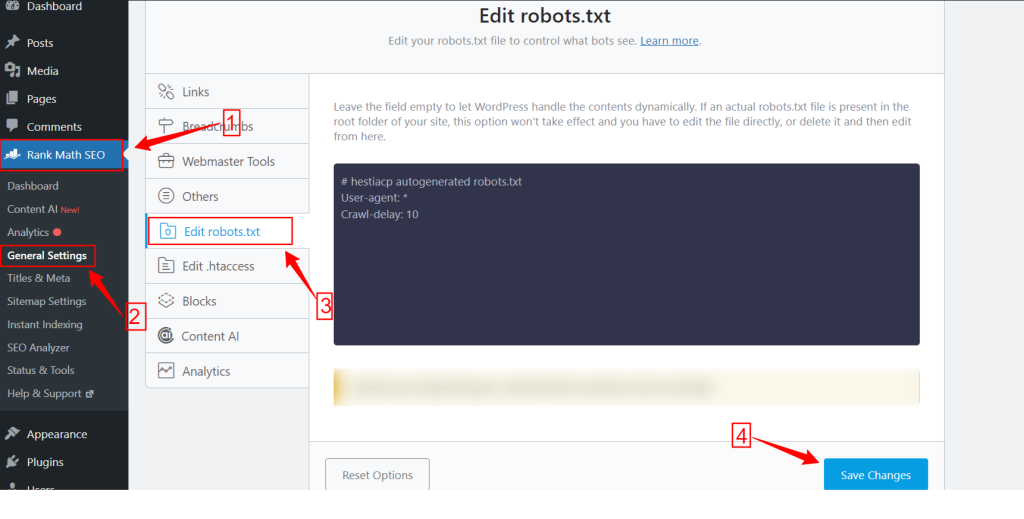

🟢 Classement Mathématiques :

Lorsque vous utilisez le plugin Rank Math, accédez au tableau de bord Rank Math dans votre tableau de bord WordPress et cliquez sur réglages généraux. Ensuite, sélectionnez le Modifier le fichier robots.txt languette. Apportez vos modifications et modifiez sur l'écran robots.txt et appuyez sur le bouton Sauvegarder les modifications bouton une fois que vous avez terminé.

Attention : Vous devez supprimer le fichier robots.txt par défaut du dossier racine du site Web à l'aide du client FTP.

Méthode 2 : créer manuellement un fichier Robots.txt à l’aide de FTP

Le processus manuel d'ajout d'un fichier robots.txt nécessite que vous accédiez à l'hébergement WordPress à l'aide d'un client FTP comme FileZilla, WinSCP et Cyberduck. Les informations de connexion FTP sont disponibles dans cPanel.

Comme vous le savez, le fichier robots.txt doit être téléchargé dans le dossier racine du site Web, vous ne pouvez donc le placer dans aucun sous-répertoire.

Vous pouvez également créer un fichier robots.txt dans le client FTP s'il n'y en a pas. Depuis votre ordinateur local, ouvrez un simple éditeur de texte comme le Bloc-notes et entrez les directives ci-dessous :

Interdire : /wp-admin/

Autoriser : /wp-admin/admin-ajax.php

Enregistrez ce fichier sous robots.txt. Maintenant, dans le client FTP, recherchez le «Téléchargement de fichiers" et téléchargez le fichier robots.txt dans le dossier racine du site Web.

Maintenant, pour ouvrir votre fichier robots.txt nouvellement créé ou le précédent, faites un clic droit dessus et sélectionnez le «Modifier" option. Faites vos modifications et éditez, puis appuyez sur le bouton Sauvegarder option. Maintenant, vérifiez votre fichier robots.txt en ajoutant le fichier robots.txt après votre nom de domaine. Par exemple, votredomaine.com/robots.txt.

Comment optimiser votre robots.txt WordPress pour le référencement

Maintenant que nous savons comment créer et modifier un fichier robots.txt sur un site WordPress, concentrons-nous sur les bonnes pratiques pour optimiser le fichier robots.txt pour votre site WordPress.

✅ Créer un fichier concis

L'ajout d'un simple fichier robots.txt aide les robots du robot à comprendre facilement vos directives, afin qu'ils consomment moins de ressources. De plus, vous pouvez éviter tout risque indésirable résultant de conflits ou d’erreurs.

✅ Exclure les répertoires et fichiers WP

Nous ne devrions pas laisser certains fichiers et répertoires être explorés par les robots de recherche, car ces zones contiennent des informations essentielles et sensibles. Lorsque vous excluez ces liens du fichier robots.txt, les robots de recherche ne visiteront pas ces zones de votre site Web. Par conséquent, vous pouvez garantir une utilisation optimale des ressources d’analyse.

Faisons connaissance avec certains des répertoires et fichiers WP :

/wp-admin/ et /wp-includes/ : Ces répertoires peuvent donner accès à la zone d'administration et aux fichiers principaux qui font fonctionner l'ensemble du site Web WordPress, ce qui peut constituer une menace pour la sécurité. Si les robots de recherche explorent ces zones, cela peut constituer une menace de sécurité cruciale. Nous devons donc augmenter les directives Disallow.

Interdire : /wp-includes/

Page de connexion: Une autre mesure de sécurité importante consiste à désindexer la page de connexion. Pour arrêter l'exploration :

readme.html : La page Lisez-moi peut révéler des informations cruciales telles que la version WordPress actuelle de votre site Web aux pirates potentiels. Pensez donc également à le désindexer.

Pages de balises et de catégories: Ces pages gaspillent des budgets d'exploration en raison de leur non-pertinence pour les requêtes de recherche et confondent les moteurs de recherche avec du contenu en double.

Interdire : /catégorie/

Résultats de recherche: La raison ci-dessus s'applique également aux pages de résultats de recherche internes.

Liens de référence : Les programmes d'affiliation produisent des liens de référence qui n'ont pas non plus besoin d'être explorés.

✅ Insérer le lien du plan du site

Généralement, les utilisateurs de WordPress soumettent leur plan de site aux comptes Google Search Console ou Bing Webmaster Tools pour suivre les analyses et les données de performances. Cependant, l'ajout d'un plan du site au fichier robots.txt peut aider les robots d'exploration à découvrir le contenu de votre site Web.

Le plan du site aidera votre site Web à indexer plus rapidement, car les moteurs de recherche pourront facilement naviguer dans la structure et la hiérarchie de votre site Web. Vous pouvez définir les pages que vous souhaitez prioriser pour l'exploration. Une autre bonne chose est qu'un plan du site peut guider les robots d'exploration vers les dernières mises à jour de votre site Web.

✅ Utilisation efficace des caractères génériques

Les caractères génériques sont votre arme efficace pour définir des règles basées sur des modèles qui permettent aux moteurs de recherche de bloquer ou d'accéder à un groupe d'URL ou à des types de fichiers spécifiques. De cette façon, vous n'avez pas besoin de restreindre plusieurs pages séparément, ce qui prend beaucoup de temps.

Les caractères génériques sont des caractères spécialisés comme Astérisque (*) et Signe dollar ($). Décrivons-les :

Astérisque (*): Le caractère générique le plus courant est l'astérisque (*), qui applique des règles générales à un groupe ou à des URL ou types de fichiers spécifiques correspondant à un modèle.

Le code ci-dessus interdit à tout moteur de recherche d’explorer n’importe quelle partie du site Web.

Signe dollar ($) : Cela indique la fin de l'URL, vous pouvez donc autoriser ou bloquer toutes les URL qui incluent un terme spécifique comme «pdf».

Interdire : /*.jpg$

Interdire : /*.docx$

Tu peux être plus stratégique en utilisant des caractères génériques. Par exemple, vous pouvez bloquer ou autoriser :

Répertoires spécifiques : Bloquera toutes les URL commençant par /private/, y compris tous les fichiers ou sous-répertoires qu'ils contiennent.

Interdire : /privé/

URL avec des paramètres spécifiques : Bloquera toutes les URL contenant le type de paramètre de requête, tel que /category/?pdf=asc.

Interdire : /*.pdf$

Modèles spécifiques : Bloquera toutes les URL contenant le mot « checkout », telles que /product/checkout ou /cart/checkout.

Interdire : /*checkout

Autoriser des fichiers ou des répertoires spécifiques dans des répertoires bloqués : Bloquera toutes les URL sous /wp-admin/ à l'exception de admin-ajax.php

Interdire : /wp-admin/

Autoriser : /wp-admin/admin-ajax.php

✅ Utiliser les commentaires

Pour améliorer la lisibilité et la clarté de votre fichier robots.txt, vous pouvez ajouter des commentaires. Cela se fait en utilisant un signe dièse (#) au début de la ligne que vous souhaitez ajouter en commentaire.

✅ Surveiller le comportement d'exploration

Vérifiez s'il y a des problèmes d'exploration et d'indexation après avoir soumis le fichier robots.txt à l'aide d'outils de moteur de recherche tels que Google Search Console ou Bing Webmaster Tools.

✅ Spécifier des règles pour les robots de recherche

Certains experts ont également déclaré qu'une stratégie efficace consiste à créer des règles différentes pour différents robots des moteurs de recherche dans les fichiers robots.txt. Spécifier comment chaque bot accédera et explorera votre site Web vous aidera à créer votre stratégie de contenu et optimisation performance.

✅ Considérez les versions mobiles et AMP

De même, vous pouvez modifier et ajuster les directives de votre fichier robots.txt pour les versions mobile et AMP.

✅ Mettez à jour votre fichier Robots.txt

Cependant, la création d’un fichier robots.txt est votre tâche lorsque vous commencez à créer votre site Web WordPress. Cependant, vous devez fréquemment rechercher tout changement dans la structure de votre site Web et les mises à jour des algorithmes des moteurs de recherche afin de pouvoir mettre à jour le fichier robots.txt.

✅ Ne faites pas d'expérience

Le fichier robots.txt fait partie du répertoire racine du site WordPress. Par conséquent, vous ne devriez faire aucune expérience avec cela. En cas de confusion, demandez l'aide d'un expert ou conservez un simple fichier robots.txt.

✅ Vérification finale

Avant de télécharger ou de modifier le fichier robots.txt, vous devez vous assurer d'avoir effectué une dernière vérification.

Comment tester votre fichier Robots.txt

Jusqu'à présent, vous avez appris à modifier et à optimiser le fichier robots.txt sur votre site Web WordPress. Cependant, ces connaissances ne sont pas complètes sans comprendre comment les tester. Les tests sont essentiels pour garantir que les robots des moteurs de recherche explorent votre site avec précision.

Une méthode principale consiste à utiliser le outil de test robots.txt dans la console de recherche Google. Cet outil vérifie si Google explore votre site Web conformément à vos directives spécifiées.

Maintenant, si votre site Web est ajouté à la Google Search Console, connectez-vous-y. Sélectionnez votre site Web sous « Veuillez sélectionner une propriété ». L'outil commencera à récupérer le fichier robots.txt de votre site Web.

Après vérification, l'outil de test robots.txt mentionnera toutes les erreurs et avertissements de syntaxe. Il vous restera donc à les réparer et à soumettre à nouveau le fichier robots.txt.

Conclure!

Comprendre et optimiser votre fichier robots.txt est un élément crucial du référencement technique et de la gestion efficace d'un site Web. Nous espérons que ce guide complet vous expliquera comment optimiser votre robots.txt WordPress pour le référencement.

Désormais, vous pouvez facilement configurer quelles parties de votre site Web doivent être explorées par les moteurs de recherche. Dans l’ensemble, vous constaterez une amélioration de l’efficacité de l’indexation et des performances globales du site.