Archivo Robots.txt: qué es y cómo optimizarlo para SEO

El archivo robots.txt se implementa en su sitio web de WordPress para indicar a los motores de búsqueda que rastreen las URL, los archivos y los tipos que desee. Ya sea que sea un principiante o un usuario experimentado de WordPress, comprender el propósito y el uso adecuado del archivo robots.txt es crucial.

Si puede decirle a Google u otros motores de búsqueda qué contenido rastrear, puede acelerar la indexación de su contenido más relevante.

En esta guía, aprenderemos principalmente sobre:

👉 ¿Qué es el archivo robots.txt en WordPress?

👉 ¿Cómo crear un archivo robots.txt en WordPress?

👉 ¿Cómo optimizar el archivo robots.txt en WordPress?

👉 ¿Cómo probar el archivo robots.txt?

Para que pueda mejorar el rastreo y la indexación de su sitio web de WordPress.

¿Qué es un archivo Robots.txt?

Agregar un archivo Robots.txt al directorio raíz del sitio web de WordPress es una práctica común de SEO que indica a los motores de búsqueda qué páginas rastrear y cuáles ignorar. En general, los navegadores web buscan todas las páginas web disponibles públicamente de su sitio web en un proceso conocido como rastreo.

Cuando coloca un archivo robots.txt en el directorio raíz de su sitio web de WordPress, los motores de búsqueda buscan todas las URL especificadas en él para determinar cuál rastrear. Aquí, una cosa debe quedar clara: el archivo robots.txt no se utiliza para fines de indexación o no indexación. Más bien, el archivo robots.txt sólo ayuda a los robots de los motores de búsqueda a rastrear sus páginas web.

¿Qué aspecto tiene Robots.txt?

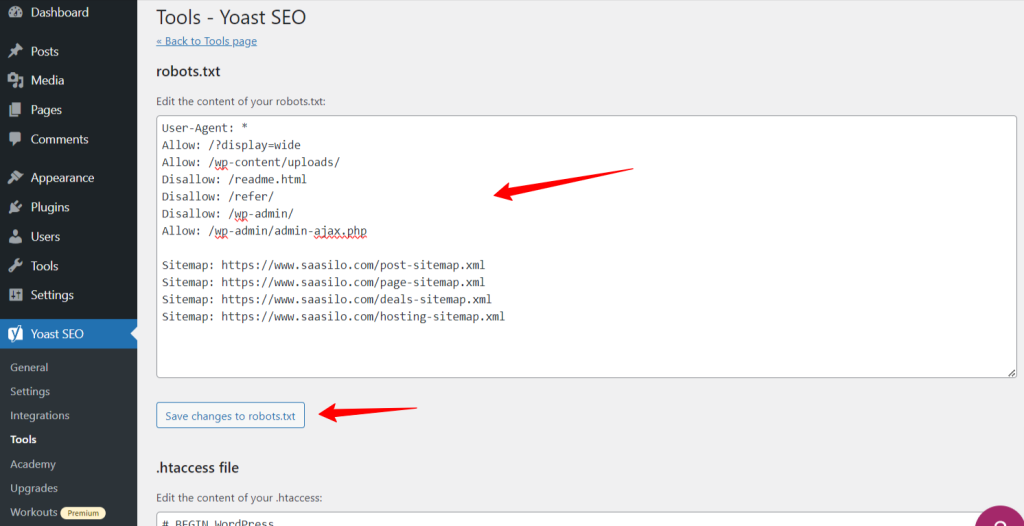

Queremos ver cómo se ve, ya que ya hemos aprendido sobre el archivo Robots.txt. Es un archivo de texto simple, no importa el tamaño del sitio web. La mayoría de los propietarios de sitios web establecen algunas reglas según sus requisitos.

A continuación se muestra un ejemplo de un archivo robots.txt:

Permitir: /?display=wide

Permitir: /wp-content/uploads/

No permitir: /readme.html

No permitir: /referir/

No permitir: /wp-admin/

Permitir: /wp-admin/admin-ajax.php

Mapa del sitio: https://www.saasilo.com/post-sitemap.xml

Mapa del sitio: https://www.saasilo.com/page-sitemap.xml

Mapa del sitio: https://www.saasilo.com/deals-sitemap.xml

Mapa del sitio: https://www.saasilo.com/hosting-sitemap.xml

En el archivo robots.txt anterior, varias reglas dictan a qué URL y rastreadores de archivos se les permite o no el acceso dentro del sitio web.

Aquí está el desglose de este archivo robots.txt:

Agente de usuario: Aplica las siguientes reglas a todos los rastreadores web.

Permitir: /?display=wide: permite a los rastreadores acceder a las URL con ?display=wide en la cadena de consulta.

Permitir: /wp-content/uploads/: Aliente a los robots de los motores de búsqueda a rastrear todos los archivos y directorios dentro de /wp-content/uploads/.

Permitir: /wp-admin/admin-ajax.php: permite a los rastreadores acceder al archivo admin-ajax.php dentro del directorio /wp-admin/.

No permitir: /readme.html: Impide que los rastreadores accedan al archivo readme.html.

No permitir: /referir/: impide que los rastreadores accedan al directorio /refer/ y a todo su contenido.

No permitir: /wp-admin/: evita que los rastreadores accedan al directorio /wp-admin/ y su contenido.

Permitir: /wp-admin/admin-ajax.php: permite a los rastreadores acceder al archivo admin-ajax.php dentro del directorio /wp-admin/.

Mapa del sitio: Por último, todas las URL vinculadas con el mapa del sitio están disponibles para que los robots de búsqueda las rastreen.

¿Necesita un archivo Robots.txt para su sitio de WordPress?

Ahora aprenderemos la importancia de un archivo robots.txt bien configurado para nuestro sitio web de WordPress. A continuación se detallan algunas funciones importantes del archivo robots.txt para administrar y optimizar el rendimiento y la visibilidad de su sitio.

➡️ Control sobre el rastreo: Los robots de los motores de búsqueda son lo suficientemente inteligentes como para descubrir todas las páginas públicas o el contenido de su sitio web. Pero queremos mantener algunas páginas privadas, ya que contienen archivos administrativos como las páginas de complementos o archivos del sistema de su sitio web de WordPress. Y el uso del archivo robots.txt le ayudará a evitar el rastreo de estas páginas irrelevantes.

➡️ Indexación más rápida para SEO: Como ya hemos dicho, el archivo robots.txt no facilita directamente la indexación de sus páginas web. Sin embargo, el archivo robots.txt aún puede acelerar el proceso de indexación. Esto sucede porque eliminas el rastreo de páginas innecesarias e irrelevantes.

➡️ Necesita menos ancho de banda: Los robots de los motores de búsqueda no necesitan navegar por todo su sitio web cuando les da instrucciones sobre qué áreas deben rastrearse. Reducirá el uso de recursos del servidor y ancho de banda. Lo que también mejora el rendimiento general de su sitio web.

➡️ Sin problema de contenido duplicado: Un error común y no deseado de los propietarios de sitios web es publicar contenido duplicado. Se engaña robots de motores de búsqueda sobre qué contenido debe indexarse o no. O bien, serán malinterpretados y el contenido original puede recibir una clasificación más baja o ser castigado. Agregar un archivo robots.txt puede garantizar que no se indexen varias versiones del mismo contenido.

➡️ Evite robots y rastreadores inseguros: Puede restringir fácilmente cualquier rastreador de spam o robot de búsqueda en un archivo robots.txt. Mejorará la seguridad de su sitio web de WordPress. Además, también puede impedir que se rastreen las páginas de administración.

¿Cómo crear un archivo Robots.txt en WordPress?

Ahora que entendemos la importancia de agregar un archivo robots.txt a nuestro sitio web de WordPress, el siguiente paso es aprender a crear uno. Con eso en mente, le mostraremos dos métodos sobre cómo crear un archivo robots.txt en su sitio web de WordPress.

Método 1: crear un archivo Robots.txt mediante el complemento

La forma más sencilla de crear y editar el archivo robots.txt es mediante un complemento. Vaya a su panel de WordPress y siga Complementos > Agregar nuevo. Ahora, instale y active un complemento SEO como Yoast SEO o Clasificar matemáticas.

Veamos su camino:

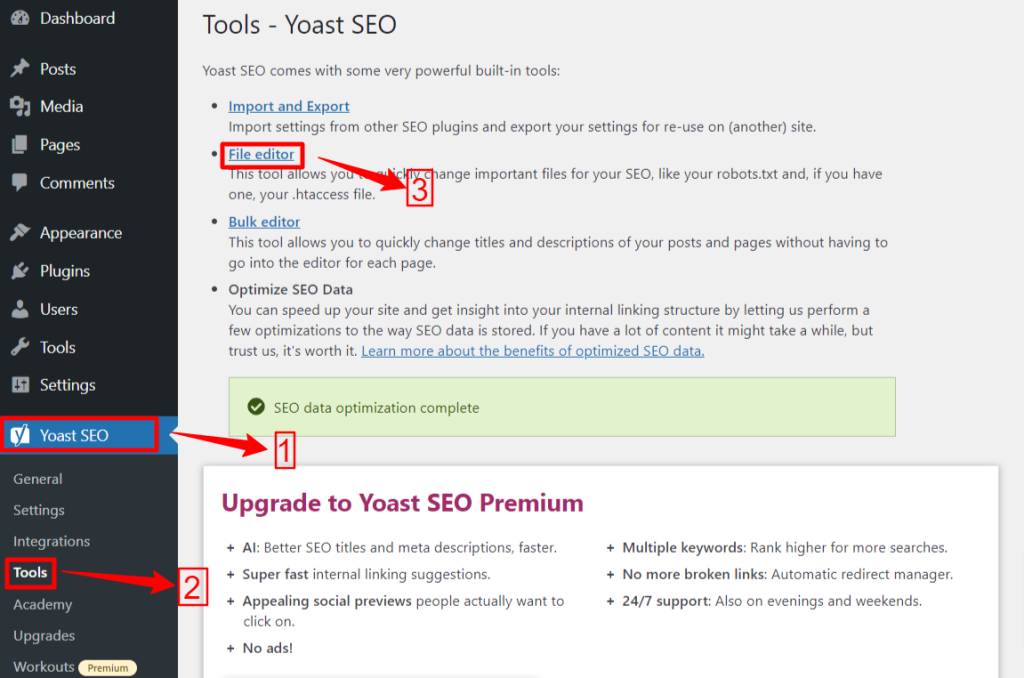

🟢 Yoast SEO:

Si está utilizando Yoast SEO, desde su área de administración de WP navegue hasta Yoast SEO > Herramientas y haga clic editor de archivos, y luego "Crear archivo Robots.txt” si no tienes ningún archivo robots.txt. A continuación, pasará a la pantalla del editor.

Después de editar o cambiar su archivo robots.txt, presione "Guardar cambios en robots.txt". Eso es todo.

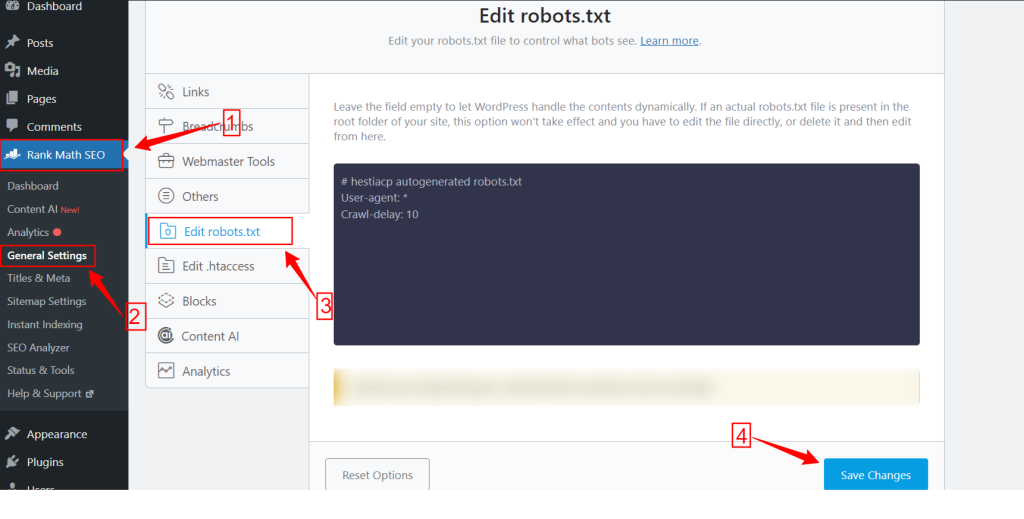

🟢 Clasificar Matemáticas:

Mientras usa el complemento Rank Math, vaya al panel de Rank Math dentro de su panel de WordPress y haga clic en Configuración general. Luego, seleccione el Editar robots.txt pestaña. Realice sus cambios y edítelos en la pantalla robots.txt y presione el Guardar cambios botón una vez que haya terminado.

NÓTESE BIEN: Debe eliminar el archivo robots.txt predeterminado de la carpeta raíz del sitio web mediante el cliente FTP.

Método 2: crear el archivo Robots.txt manualmente mediante FTP

El proceso manual de agregar un archivo robots.txt requiere que acceda al alojamiento de WordPress mediante un cliente FTP como FileZilla, WinSCP y Cyberduck. La información de inicio de sesión FTP está disponible en cPanel.

Como sabes, el archivo robots.txt debe cargarse en la carpeta raíz del sitio web, por lo que no puedes colocarlo en ningún subdirectorio.

También puedes crear un archivo robots.txt en el cliente FTP si no hay ninguno. Desde su computadora local, abra un editor de texto simple como el Bloc de notas e ingrese las siguientes directivas:

No permitir: /wp-admin/

Permitir: /wp-admin/admin-ajax.php

Guarde este archivo como robots.txt. Ahora, dentro del cliente FTP, busque el “Subir archivo”Y cargue el archivo robots.txt en la carpeta raíz del sitio web.

Ahora, para abrir su archivo robots.txt recién creado o uno anterior, haga clic derecho sobre él y seleccione "Editar" opción. Haga sus cambios y edite, luego presione el Ahorrar opción. Ahora, verifique su archivo robots.txt agregando el archivo robots.txt después de su nombre de dominio. Como por ejemplo, tudominio.com/robots.txt.

Cómo optimizar su robots.txt de WordPress para SEO

Ahora que sabemos cómo crear y editar un archivo robots.txt en un sitio web de WordPress, centrémonos en las mejores prácticas para optimizar el archivo robots.txt para su sitio de WordPress.

✅ Crear un archivo conciso

Agregar un archivo robots.txt simple ayuda a los robots del rastreador a comprender sus directivas fácilmente, por lo que consumen menos recursos. Además, puede evitar riesgos no deseados que surjan de conflictos o errores.

✅ Excluir directorios y archivos de WP

No debemos permitir que los robots de búsqueda rastreen ciertos archivos y directorios, ya que estas áreas contienen información esencial y confidencial. Cuando excluye estos enlaces del archivo robots.txt, los robots de búsqueda no visitarán estas áreas de su sitio web. Por lo tanto, puede garantizar un uso óptimo de los recursos de rastreo.

Conozcamos algunos de los directorios y archivos de WP:

/wp-admin/ y /wp-incluye/: Estos directorios pueden brindar acceso al área de administración y a los archivos principales que hacen que todo el sitio web de WordPress funcione, lo que puede ser una amenaza para la seguridad. Si los robots de búsqueda rastrean estas áreas, puede representar una amenaza crucial para la seguridad. Entonces, tenemos que aumentar las directivas Disallow.

No permitir: /wp-incluye/

Página de inicio de sesión: Otra medida de seguridad importante es desindexar la página de inicio de sesión. Para dejar de rastrear:

Léame.html: La página Léame puede revelar información crucial, como la versión actual de WordPress de su sitio web, a posibles piratas informáticos. Así que considere desindexarlo también.

Páginas de etiquetas y categorías: Estas páginas desperdician presupuestos de rastreo debido a su irrelevancia para las consultas de búsqueda y confunden a los motores de búsqueda con contenido duplicado.

No permitir: /categoría/

Resultados de la búsqueda: El motivo anterior también se aplica a las páginas de resultados de búsqueda internas.

Enlaces de referencia: Los programas de afiliados producen enlaces de referencia que tampoco necesitan ser rastreados.

✅ Insertar enlace del mapa del sitio

Generalmente, los usuarios de WordPress envían su mapa del sitio a las cuentas de Google Search Console o Bing Webmaster Tools para realizar un seguimiento de los análisis y los datos de rendimiento. Sin embargo, agregar un mapa del sitio al archivo robots.txt puede ayudar a los rastreadores a descubrir el contenido de su sitio web.

El mapa del sitio ayudará a que su sitio web se indexe más rápido, ya que los motores de búsqueda pueden navegar fácilmente por la estructura y jerarquía de su sitio web. Puede definir las páginas que desea priorizar para el rastreo. Otra cosa buena es que un mapa del sitio puede guiar a los rastreadores hacia las últimas actualizaciones de su sitio web.

✅ Uso eficaz de comodines

Los comodines son su arma eficaz para definir reglas basadas en patrones que permiten a los motores de búsqueda bloquear o acceder a un grupo de URL o tipos de archivos específicos. De esa manera, no es necesario restringir varias páginas por separado y consumir mucho tiempo.

Los comodines son caracteres especializados como Asterisco (*) y Signo de dólar ($). Vamos a describirlos:

Asterisco (*): El comodín más común es el asterisco (*), que aplica reglas de manera amplia para un grupo o URL o tipos de archivos que coinciden con patrones específicos.

El código anterior no permite que ningún motor de búsqueda rastree ninguna parte del sitio web.

Signo de dólar ($): Esto indica el final de la URL, por lo que puedes permitir o bloquear cualquier URL que incluya un término específico como "pdf”.

No permitir: /*.jpg$

No permitir: /*.docx$

Usted puede ser más estratégico mediante el uso de comodines. Me gusta, puedes bloquear o permitir:

Directorios específicos: Bloqueará cualquier URL que comience con /privada/, incluidos los archivos o subdirectorios que contenga.

No permitir: /privado/

URL con parámetros específicos: Bloqueará todas las URL que contengan el parámetro de consulta tipo, como /category/?pdf=asc.

No permitir: /*.pdf$

Patrones específicos: Bloqueará todas las URL que incluyan la palabra "pagar", como /producto/pagar o /carrito/pagar.

No permitir: /*pagar

Permitir archivos o directorios específicos dentro de directorios bloqueados: Bloqueará todas las URL en /wp-admin/ excepto admin-ajax.php

No permitir: /wp-admin/

Permitir: /wp-admin/admin-ajax.php

✅ Usar comentarios

Para mejorar la legibilidad y claridad de su archivo robots.txt, puede agregar comentarios. Esto se hace usando un signo de almohadilla (#) al comienzo de la línea que desea agregar como comentario.

✅ Monitorear el comportamiento de rastreo

Compruebe si hay problemas de rastreo e indexación después de enviar el archivo robots.txt utilizando herramientas de motores de búsqueda como Google Search Console o Bing Webmaster Tools.

✅ Especificar reglas para robots de búsqueda

Algunos expertos también afirmaron que una estrategia eficaz es crear diferentes reglas para diferentes robots de motores de búsqueda en archivos robots.txt. Especificar cómo cada bot accederá y rastreará su sitio web le ayudará a construir su estrategia de contenidos y optimización actuación.

✅ Considere las versiones móviles y AMP

De manera similar, puede cambiar y ajustar las directivas de su archivo robots.txt para versiones móviles y AMP.

✅ Actualice su archivo Robots.txt

Sin embargo, crear un archivo robots.txt es su tarea cuando comience a crear su sitio web de WordPress. Sin embargo, debe buscar con frecuencia cambios en la estructura de su sitio web y actualizaciones del algoritmo del motor de búsqueda para poder actualizar el archivo robots.txt.

✅ No hagas experimentos

El archivo robots.txt forma parte del directorio raíz del sitio web de WordPress. Por lo tanto, no deberías hacer ningún experimento con él. En caso de confusión, busque ayuda de un experto o guarde un archivo robots.txt simple.

✅ Revision final

Antes de cargar o editar el archivo robots.txt, debe asegurarse de haber realizado una verificación final.

Cómo probar su archivo Robots.txt

Hasta este punto, has aprendido cómo editar y optimizar el archivo robots.txt en tu sitio web de WordPress. Sin embargo, este conocimiento no está completo sin saber cómo probarlo. Las pruebas son cruciales para garantizar que los robots de los motores de búsqueda estén rastreando su sitio con precisión.

Un método principal es utilizar el herramienta de prueba robots.txt en la consola de búsqueda de Google. Esta herramienta verifica si Google está rastreando su sitio web de acuerdo con las directivas especificadas.

Ahora, si su sitio web está agregado a Google Search Console, inicie sesión. Seleccione su sitio web en "Seleccione una propiedad". La herramienta comenzará a buscar el archivo robots.txt de su sitio web.

Después de la verificación, la herramienta de prueba de robots.txt mencionará todos los errores y advertencias de sintaxis. Por lo tanto, deberá solucionarlos y enviar el archivo robots.txt nuevamente.

¡Envolver!

Comprender y optimizar su archivo robots.txt es una parte crucial del SEO técnico y de la gestión eficaz de un sitio web. Esperamos esta guía completa sobre cómo optimizar su robots.txt de WordPress para SEO.

Ahora, puede configurar fácilmente qué partes de su sitio web deben ser rastreadas por los motores de búsqueda. En general, verá una mejora en la eficiencia de indexación y el rendimiento general del sitio.