Robots.txt-fil: Hvad er det, og hvordan man optimerer det til SEO

Robots.txt-filen er implementeret på dit WordPress-websted for at signalere søgemaskiner til at crawle de URL'er, filer og typer, du ønsker. Uanset om du er nybegynder eller erfaren WordPress-bruger, er det afgørende at forstå formålet og den korrekte brug af robots.txt-filen.

Hvis du kan fortælle Google eller andre søgemaskiner, hvilket indhold der skal gennemgås, kan det fremskynde indekseringen af dit mest relevante indhold.

I denne guide vil vi hovedsageligt lære om:

👉 Hvad er robots.txt-fil i WordPress?

👉 Hvordan opretter man robots.txt-fil i WordPress?

👉 Hvordan optimerer man robots.txt-filen i WordPress?

👉 Hvordan tester man robots.txt-fil?

Så du kan forbedre din WordPress-websites crawling og indeksering.

Hvad er en Robots.txt-fil?

Tilføjelse af en Robots.txt-fil til WordPress-webstedets rodmappe er en almindelig SEO-praksis, der instruerer søgemaskiner på, hvilke sider de skal gennemgå, og hvilke de skal ignorere. Generelt søger webbrowsere alle de offentligt tilgængelige websider på dit websted i en proces, der kaldes crawl.

Når du placerer en robots.txt-fil i dit WordPress-websteds rodmappe, leder søgemaskinerne efter alle de URL'er, der er angivet i den for at bestemme, hvilke der skal crawles. Her bør én ting være klar: robots.txt-filen bruges ikke til indeks- eller ikke-indeksformål. I stedet hjælper robots.txt-filen kun søgemaskinerobotter med at crawle dine websider.

Hvordan ser Robots.txt ud?

Vi vil gerne se, hvordan det ser ud, da vi allerede har lært om Robots.txt-filen. Det er en simpel tekstfil, det er lige meget hvor stor en hjemmeside er. De fleste webstedsejere sætter nogle få regler baseret på deres krav.

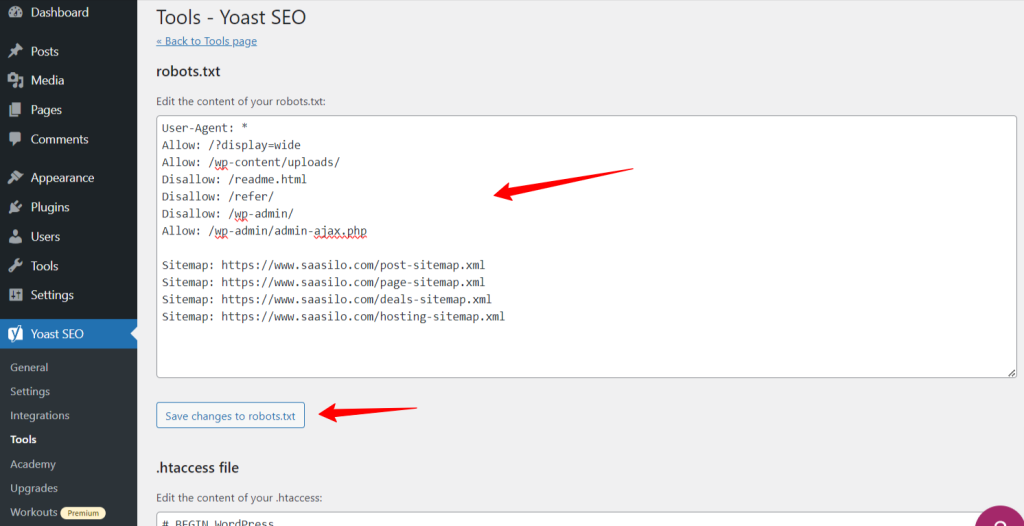

Her er et eksempel på en robots.txt-fil:

Tillad: /?display=wide

Tillad: /wp-content/uploads/

Disallow: /readme.html

Disallow: /refer/

Disallow: /wp-admin/

Tillad: /wp-admin/admin-ajax.php

Sitemap: https://www.saasilo.com/post-sitemap.xml

Sitemap: https://www.saasilo.com/page-sitemap.xml

Sitemap: https://www.saasilo.com/deals-sitemap.xml

Sitemap: https://www.saasilo.com/hosting-sitemap.xml

I robots.txt-filen ovenfor dikterer forskellige regler, hvilke URL'er og filcrawlere, der tillades eller ikke må få adgang på webstedet.

Her er opdelingen af denne robots.txt-fil:

Bruger-agent: Gælder følgende regler for alle webcrawlere.

Tillad: /?display=wide: Tillader crawlere at få adgang til webadresser med ?display=wide i forespørgselsstrengen.

Tillad: /wp-content/uploads/: Tilskynd søgemaskinebots til at gennemgå alle filer og mapper i /wp-content/uploads/.

Tillad: /wp-admin/admin-ajax.php: Tillader crawlere at få adgang til filen admin-ajax.php i mappen /wp-admin/.

Disallow: /readme.html: Forhindrer crawlere i at få adgang til filen readme.html.

Disallow: /refer/: Blokerer crawlere fra at få adgang til /refer/-biblioteket og alt dets indhold.

Disallow: /wp-admin/: Forhindrer crawlere i at få adgang til mappen /wp-admin/ og dens indhold.

Tillad: /wp-admin/admin-ajax.php: Tillader crawlere at få adgang til filen admin-ajax.php i mappen /wp-admin/.

Sitemap: Endelig er alle de webadresser, der er linket til sitemappet, tilgængelige for gennemgang af søgerobotter.

Har du brug for en Robots.txt-fil til dit WordPress-websted?

Nu lærer vi vigtigheden af en velkonfigureret robots.txt-fil til vores WordPress-websted. Her er nogle vigtige roller i robots.txt-filen til at administrere og optimere dit websteds ydeevne og synlighed.

➡️ Kontrol over gennemgang: Søgemaskinebots er smarte nok til at finde ud af alle dit websteds offentlige sider eller indhold. Men vi ønsker at holde nogle sider private, da de indeholder administrative filer som plugin-sider eller systemfiler på dit WordPress-websted. Og brug af robots.txt-filen vil hjælpe dig med at forhindre gennemgang af disse irrelevante sider.

➡️ Hurtigere indeksering til SEO: Som vi allerede har sagt, letter robots.txt-filen ikke direkte indeksering af dine websider. Robots.txt-filen kan dog stadig fremskynde indekseringsprocessen. Dette sker, fordi du fjerner unødvendige og irrelevante sider fra at blive crawlet.

➡️ Brug for mindre båndbredde: Søgemaskinebots behøver ikke at surfe over hele dit websted, når du giver dem anvisninger på, hvilke områder der skal gennemsøges. Det vil mindske brugen af serverressourcer og båndbredde. Hvilket også forbedrer din overordnede hjemmesideydelse.

➡️ Intet duplikatindholdsproblem: En uønsket almindelig bommert blandt webstedsejere er at udgive duplikeret indhold. Det bedrager søgemaskine-bots om, hvilket indhold der skal indekseres eller ej. Ellers vil de blive misforstået, og det originale indhold kan blive rangeret lavere eller straffet. Tilføjelse af en robots.txt-fil kan sikre, at der ikke vil være nogen indeksering af flere versioner af det samme indhold.

➡️ Undgå usikre bots og crawlere: Du kan nemt begrænse alle spammy-crawlere eller søgerobotter i en robots.txt-fil. Det vil øge sikkerheden på dit WordPress-websted. Yderligere kan du også forhindre, at admin-siderne bliver crawlet.

Hvordan opretter man en Robots.txt-fil i WordPress?

Nu hvor vi forstår vigtigheden af at tilføje en robots.txt-fil til vores WordPress-websted, er næste trin at lære, hvordan man opretter en. Med det i tankerne viser vi dig to metoder til, hvordan du opretter en robots.txt-fil på dit WordPress-websted.

Metode 1: Opret en Robots.txt-fil ved hjælp af plugin

Den nemmeste måde at oprette og redigere robots.txt-filen på er ved at bruge et plugin. Gå til dit WordPress-dashboard, og følg Plugins > Tilføj nyt. Installer og aktiver nu et SEO-plugin som Yoast SEO eller Rang Math.

Lad os se deres vej:

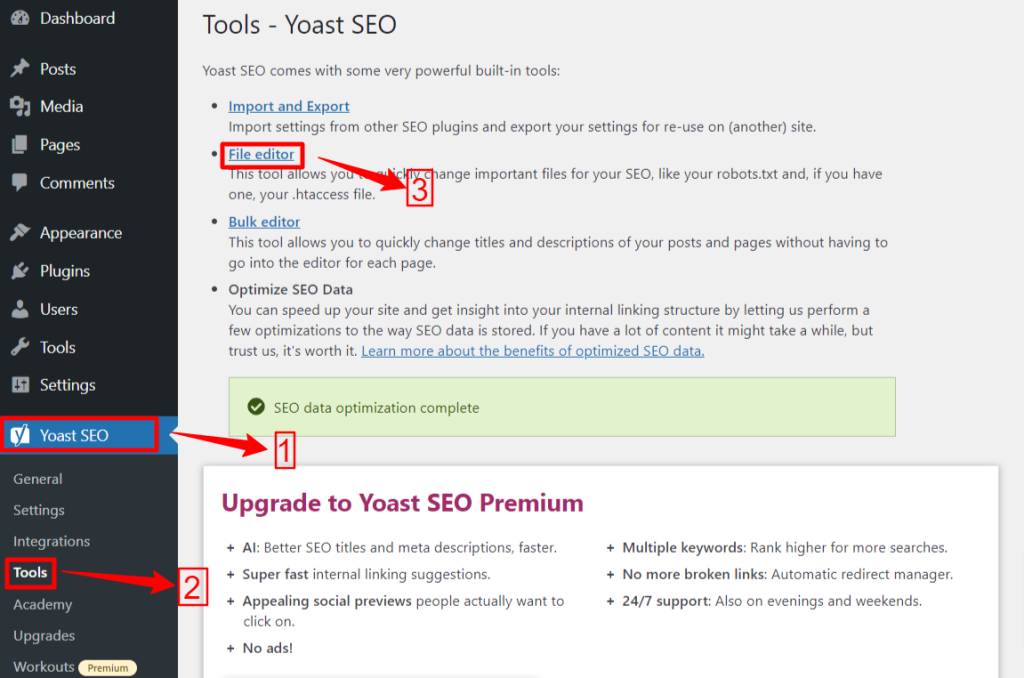

Yoast SEO:

Hvis du bruger Yoast SEO, skal du fra dit WP-administrationsområde navigere til Yoast SEO > Værktøjer og klik Fil editor, og så "Opret Robots.txt-fil" hvis du ikke har nogen robots.txt-fil. Dernæst vil du gå til redigeringsskærmen.

Når du har redigeret eller ændret din robots.txt-fil, skal du trykke på "Gem ændringer til robots.txt". Det er det.

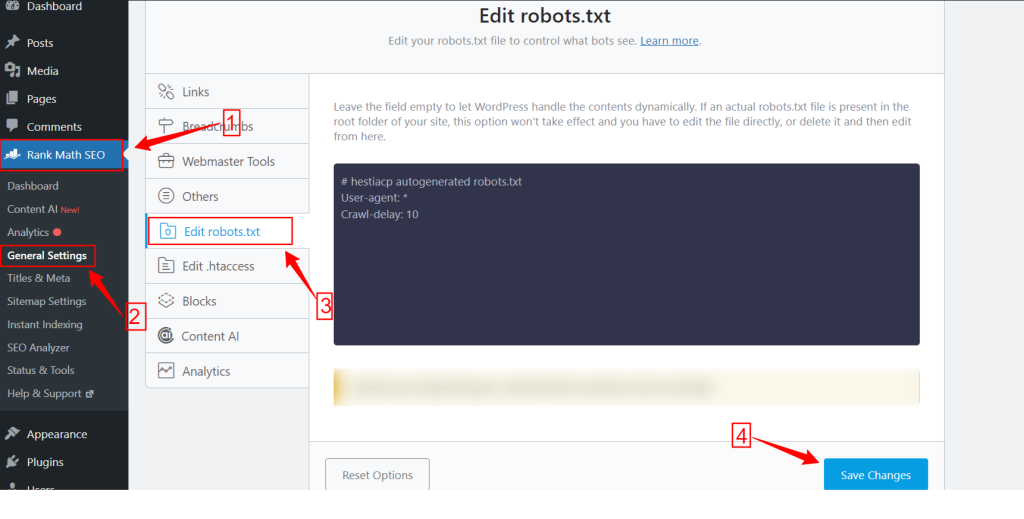

Rank matematik:

Mens du bruger Rank Math-pluginnet, skal du gå til Rank Math-dashboardet i dit WordPress-dashboard og klikke Generelle indstillinger. Vælg derefter Rediger robots.txt fanen. Foretag dine ændringer og rediger på robots.txt-skærmen og tryk på Gem ændringer knappen, når du er færdig.

NB: Du skal slette standard robots.txt-filen fra webstedets rodmappe ved hjælp af FTP-klienten.

Metode 2: Opret Robots.txt-fil manuelt ved hjælp af FTP

Den manuelle proces med at tilføje en robots.txt-fil kræver, at du får adgang til WordPress-hosting ved hjælp af en FTP-klient som FileZilla, WinSCP og Cyberduck. FTP-loginoplysninger er tilgængelige i cPanel.

Som du ved, skal robots.txt-filen uploades til rodmappen på hjemmesiden, så du kan ikke placere den i nogen undermappe.

Du kan også oprette en robots.txt-fil i FTP-klienten, hvis der ikke er nogen. Fra din lokale computer skal du åbne en simpel teksteditor som Notesblok og indtaste nedenstående direktiver:

Disallow: /wp-admin/

Tillad: /wp-admin/admin-ajax.php

Gem denne fil som robots.txt. I FTP-klienten skal du nu se efter "Fil upload” og upload robots.txt-filen til webstedets rodmappe.

For nu at åbne din nyoprettede robots.txt-fil eller den forrige, skal du højreklikke på den og vælge "Redigere" mulighed. Foretag dine ændringer og rediger, og tryk derefter på Gemme mulighed. Tjek nu din robots.txt-fil ved at tilføje robots.txt-filen efter dit domænenavn. Såsom ditdomæne.com/robots.txt.

Sådan optimerer du din WordPress robots.txt til SEO

Nu hvor vi ved, hvordan man opretter og redigerer en robots.txt-fil på et WordPress-websted, så lad os fokusere på bedste praksis for at optimere robots.txt-filen til dit WordPress-websted.

✅ Opret en kortfattet fil

Tilføjelse af en simpel robots.txt-fil hjælper crawlerens bots med nemt at forstå dine direktiver, så de bruger færre ressourcer. Derudover kan du undgå uønskede risici, der opstår fra konflikter eller fejl.

✅ Udelad WP-mapper og -filer

Vi bør ikke lade visse filer og mapper blive gennemgået af søgerobotterne, da disse områder indeholder væsentlige og følsomme oplysninger. Når du ekskluderer disse links fra robots.txt-filen, besøger søgerobotter ikke disse områder af dit websted. Derfor kan du sikre optimal udnyttelse af crawl-ressourcer.

Lad os lære nogle af WP-bibliotekerne og filerne at kende:

/wp-admin/ og /wp-inkluderer/: Disse mapper kan give adgang til administrationsområdet og kernefiler, der får hele WordPress-webstedet til at fungere, hvilket kan være en sikkerhedstrussel. Hvis søgerobotter gennemgår disse områder, kan det være en afgørende sikkerhedstrussel. Så vi er nødt til at ophæve Disallow-direktiver.

Disallow: /wp-includes/

Login side: En anden vigtig sikkerhedsforanstaltning er at afindeksere login-siden. Sådan stopper du crawl:

readme.html: Readme-siden kan afsløre afgørende information som den aktuelle WordPress-version af dit websted til potentielle hackere. Så overvej også at deindeksere det.

Tag- og kategorisider: Disse sider spilder crawl-budgetter på grund af deres irrelevans for søgeforespørgsler og forvirrer søgemaskiner med duplikeret indhold.

Disallow: /category/

Søgeresultater: Ovenstående årsag gælder også for de interne søgeresultatsider.

Henvisningslinks: Tilknyttede programmer producerer henvisningslinks, der ikke også behøver at blive crawlet.

✅ Indsæt sitemaplink

Generelt indsender WordPress-brugere deres sitemap til Google Search Console eller Bing Webmaster Tools-konti for at spore analyse- og ydeevnedata. Men tilføjelse af et sitemap til robots.txt-filen kan hjælpe crawlere med at finde indholdet på dit websted.

Sitemap vil hjælpe dit websted med at indeksere hurtigere, da søgemaskiner nemt kan navigere i dit websteds struktur og hierarki. Du kan definere de sider, du vil prioritere til gennemgang. En anden god ting er, at et sitemap kan guide crawlere til de seneste opdateringer på din hjemmeside.

✅ Effektiv brug af jokertegn

Jokertegn er dit effektive våben til at definere mønsterbaserede regler, der tillader søgemaskiner at blokere eller få adgang til en gruppe af URL'er eller specifikke filtyper. På den måde behøver du ikke begrænse flere sider hver for sig og bruge meget tid.

Jokertegn er specialiserede karakterer som f.eks Stjerne (*) og Dollartegn ($). Lad os beskrive dem:

Stjerne (*): Det mest almindelige jokertegn er Asterisk (*), som anvender regler bredt for en gruppe eller specifikke mønstermatchede URL'er eller filtyper.

Ovenstående kode forhindrer enhver søgemaskine i at crawle nogen del af webstedet.

Dollartegn ($): Dette angiver slutningen af webadressen, så du kan tillade eller blokere alle webadresser, der indeholder et specifikt udtryk som "pdf”.

Disallow: /*.jpg$

Disallow: /*.docx$

Du kan være mere strategisk ved at bruge jokertegn. Ligesom, du kan blokere eller tillade:

Specifikke mapper: Blokerer alle URL'er, der starter med /private/, inklusive alle filer eller undermapper i den.

Disallow: /privat/

Webadresser med specifikke parametre: Blokerer alle URL'er, der indeholder forespørgselsparametersorteringen, såsom /category/?pdf=asc.

Disallow: /*.pdf$

Specifikke mønstre: Blokerer alle URL'er, der indeholder ordet "checkout", som f.eks /product/checkout eller /cart/checkout.

Disallow: /*checkout

Tilladelse af specifikke filer eller mapper i blokerede mapper: Blokerer alle URL'er under /wp-admin/ undtagen admin-ajax.php

Disallow: /wp-admin/

Tillad: /wp-admin/admin-ajax.php

✅ Brug kommentarer

For at forbedre læsbarheden og klarheden af din robots.txt-fil kan du tilføje kommentarer. Dette gøres ved at bruge et hash-tegn (#) i begyndelsen af den linje, du vil tilføje som en kommentar.

✅ Overvåg kravleadfærd

Tjek, om der er nogen crawl- og indekseringsproblemer efter indsendelse af robots.txt-filen ved hjælp af søgemaskineværktøjer som Google Search Console eller Bing Webmaster Tools.

✅ Angiv regler for søgebots

Nogle eksperter udtalte også, at en effektiv strategi er at skabe forskellige regler for forskellige søgemaskinebots i robots.txt-filer. At specificere, hvordan hver bot vil få adgang til og crawle dit websted, vil hjælpe dig med at opbygge din indholdsstrategi og optimer ydeevne.

✅ Overvej mobil- og AMP-versioner

På samme måde kan du ændre og justere direktiverne for din robots.txt-fil til mobil- og AMP-versioner.

✅ Opdater din Robots.txt-fil

Selvom det er din opgave at oprette en robots.txt-fil, når du begynder at bygge dit WordPress-websted. Du skal dog ofte kigge efter ændringer i dit websteds struktur og opdateringer af søgemaskinealgoritmer, så du kan opdatere robots.txt-filen.

✅ Foretag ikke eksperiment

Robots.txt-filen er en del af WordPress-webstedets rodmappe. Derfor bør du ikke lave nogen eksperimenter med det. For enhver forvirring, tag eksperthjælp eller behold en simpel robots.txt-fil.

✅ Endelig kontrol

Før du uploader eller redigerer robots.txt-filen, skal du sikre dig, at du har foretaget en sidste kontrol.

Sådan tester du din Robots.txt-fil

Indtil dette tidspunkt har du lært, hvordan du redigerer og optimerer robots.txt-filen på dit WordPress-websted. Denne viden er dog ikke komplet uden at forstå, hvordan man tester den. Test er afgørende for at sikre, at søgemaskine-bots crawler dit websted præcist.

En primær metode er at bruge robots.txt testværktøj i Google Search Console. Dette værktøj verificerer, om Google crawler dit websted i henhold til dine specificerede direktiver.

Hvis dit websted nu er føjet til Google Search Console, skal du logge ind på det. Vælg din hjemmeside under "Vælg venligst en ejendom". Værktøjet begynder at hente dit websteds robots.txt-fil.

Efter verificeringen vil robots.txt-testværktøjet nævne alle fejl og syntaksadvarsler. Så du vil stå tilbage med at rette dem og indsende robots.txt-filen igen.

Afslut!

Forståelse og optimering af din robots.txt-fil er en afgørende del af teknisk SEO og effektiv hjemmesidestyring. Vi håber denne omfattende guide til, hvordan du optimerer din WordPress robots.txt til SEO.

Nu kan du nemt konfigurere, hvilke dele af dit websted, der skal crawles af søgemaskiner. Samlet set vil du se en forbedring i webstedets indekseringseffektivitet og overordnede ydeevne.