Robots.txt-fil: Vad är det och hur man optimerar det för SEO

Robots.txt-filen implementeras på din WordPress-webbplats för att signalera sökmotorer att genomsöka de webbadresser, filer och typer du vill ha. Oavsett om du är nybörjare eller en erfaren WordPress-användare är det avgörande att förstå syftet med och korrekt användning av robots.txt-filen.

Om du kan tala om för Google eller andra sökmotorer vilket innehåll som ska genomsökas, kan det påskynda indexeringen av ditt mest relevanta innehåll.

I den här guiden kommer vi främst att lära oss om:

👉 Vad är robots.txt-fil i WordPress?

👉 Hur skapar jag en robots.txt-fil i WordPress?

👉 Hur optimerar man robots.txt-filen i WordPress?

👉 Hur testar man robots.txt-filen?

Så du kan förbättra din WordPress-webbplats genomsökning och indexering.

Vad är en Robots.txt-fil?

Att lägga till en Robots.txt-fil i WordPress-webbplatsens rotkatalog är en vanlig SEO-praxis som instruerar sökmotorer på vilka sidor de ska genomsöka och vilka de ska ignorera. I allmänhet söker webbläsare alla offentligt tillgängliga webbsidor på din webbplats i en process som kallas genomsökning.

När du placerar en robots.txt-fil i din WordPress-webbplats rotkatalog, letar sökmotorer efter alla webbadresser som anges i den för att avgöra vilka som ska genomsökas. Här bör en sak vara tydlig: robots.txt-filen används inte för index- eller ickeindexändamål. Snarare hjälper robots.txt-filen bara sökmotorrobotar att genomsöka dina webbsidor.

Hur ser Robots.txt ut?

Vi vill se hur det ser ut eftersom vi redan har lärt oss om filen Robots.txt. Det är en enkel textfil, det spelar ingen roll hur stor en webbplats är. De flesta webbplatsägare sätter några regler baserat på deras krav.

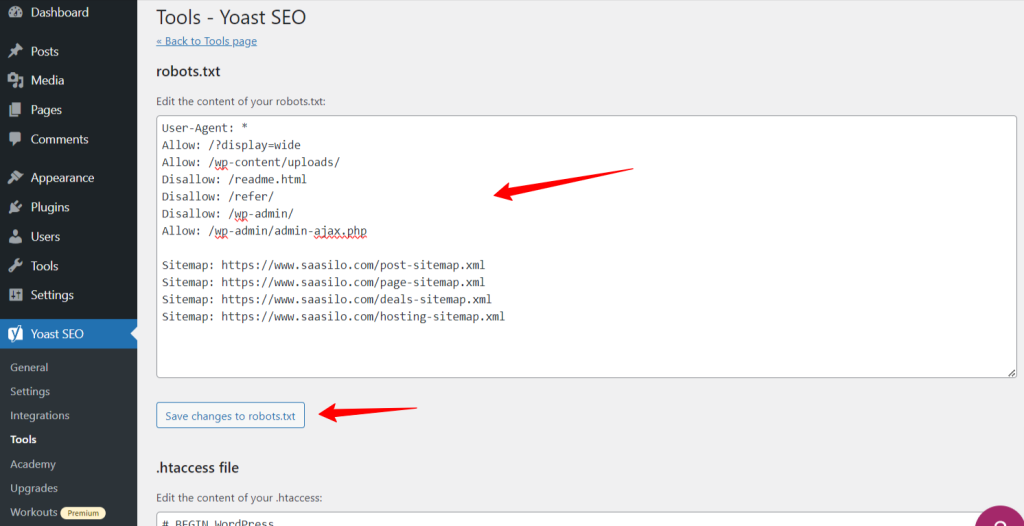

Här är ett exempel på en robots.txt-fil:

Tillåt: /?display=wide

Tillåt: /wp-content/uploads/

Disallow: /readme.html

Disallow: /refer/

Disallow: /wp-admin/

Tillåt: /wp-admin/admin-ajax.php

Webbplatskarta: https://www.saasilo.com/post-sitemap.xml

Webbplatskarta: https://www.saasilo.com/page-sitemap.xml

Webbplatskarta: https://www.saasilo.com/deals-sitemap.xml

Webbplatskarta: https://www.saasilo.com/hosting-sitemap.xml

I robots.txt-filen ovan dikterar olika regler vilka webbadresser och sökrobotar som tillåts eller inte tillåts komma åt på webbplatsen.

Här är uppdelningen av denna robots.txt-fil:

Användaragent: Tillämpar följande regler på alla sökrobotar.

Tillåt: /?display=wide: Tillåter sökrobotar att komma åt webbadresser med ?display=wide i frågesträngen.

Tillåt: /wp-content/uploads/: Uppmuntra sökmotorrobotar att genomsöka alla filer och kataloger inom /wp-content/uploads/.

Tillåt: /wp-admin/admin-ajax.php: Tillåter sökrobotar att komma åt filen admin-ajax.php i katalogen /wp-admin/.

Disallow: /readme.html: Förhindrar sökrobotar från att komma åt filen readme.html.

Disallow: /refer/: Blockerar sökrobotar från att komma åt /refer/-katalogen och allt dess innehåll.

Disallow: /wp-admin/: Förhindra sökrobotar från att komma åt katalogen /wp-admin/ och dess innehåll.

Tillåt: /wp-admin/admin-ajax.php: Tillåter sökrobotar att komma åt filen admin-ajax.php i katalogen /wp-admin/.

Webbplatskarta: Slutligen är alla webbadresser som är länkade till webbplatskartan tillgängliga för genomsökning av sökrobotar.

Behöver du en Robots.txt-fil för din WordPress-webbplats?

Nu ska vi lära oss vikten av en välkonfigurerad robots.txt-fil för vår WordPress-webbplats. Här är några viktiga roller för robots.txt-filen för att hantera och optimera din webbplats prestanda och synlighet.

➡️ Kontroll över genomsökning: Sökmotorrobotar är smarta nog att ta reda på alla din webbplats offentliga sidor eller innehåll. Men vi vill hålla vissa sidor privata eftersom de innehåller administrativa filer som plugin-sidor eller systemfiler på din WordPress-webbplats. Och att använda robots.txt-filen hjälper dig att förhindra genomsökning av dessa irrelevanta sidor.

➡️ Snabbare indexering för SEO: Som vi redan har sagt underlättar robots.txt-filen inte direkt indexering av dina webbsidor. Men robots.txt-filen kan fortfarande påskynda indexeringsprocessen. Detta beror på att du tar bort onödiga och irrelevanta sidor från att genomsökas.

➡️ Behöver mindre bandbredd: Sökmotorrobotar behöver inte surfa över hela din webbplats när du ger dem anvisningar om vilka områden som måste genomsökas. Det kommer att minska användningen av serverresurser och bandbredd. Vilket också förbättrar din övergripande webbplatsprestanda.

➡️ Inget duplicerat innehållsproblem: En oönskad vanlig blunder hos webbplatsägare är att publicera duplicerat innehåll. Det lurar sökmotorbotar om vilket innehåll som ska indexeras eller inte. Eller så kommer de att missförstås och det ursprungliga innehållet kan rankas lägre eller straffas. Att lägga till en robots.txt-fil kan säkerställa att det inte blir någon indexering av flera versioner av samma innehåll.

➡️ Undvik osäkra bots och sökrobotar: Du kan enkelt begränsa alla spammiga sökrobotar eller sökrobotar i en robots.txt-fil. Det kommer att förbättra säkerheten för din WordPress-webbplats. Dessutom kan du inte tillåta att administratörssidorna genomsöks.

Hur skapar jag en Robots.txt-fil i WordPress?

Nu när vi förstår vikten av att lägga till en robots.txt-fil på vår WordPress-webbplats, är nästa steg att lära sig hur man skapar en. Med det i åtanke kommer vi att visa dig två metoder för hur du skapar en robots.txt-fil på din WordPress-webbplats.

Metod 1: Skapa en Robots.txt-fil med plugin

Det enklaste sättet att skapa och redigera robots.txt-filen är att använda en plugin. Gå till din WordPress-instrumentpanel och följ Plugins > Lägg till nytt. Installera och aktivera nu ett SEO-plugin som Yoast SEO eller Rank Math.

Låt oss se deras väg:

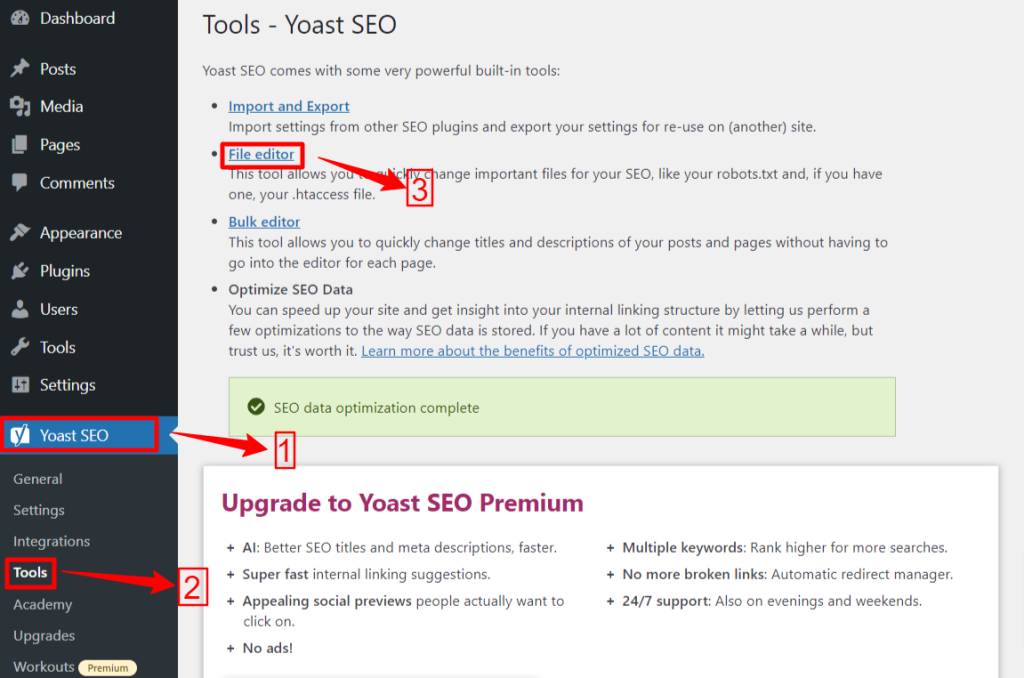

Yoast SEO:

Om du använder Yoast SEO, från ditt WP-administratörsområde, navigera till Yoast SEO > Verktyg och klicka Filredigerare, och då "Skapa Robots.txt-fil” om du inte har någon robots.txt-fil. Därefter kommer du att gå till redigeringsskärmen.

När du har redigerat eller ändrat din robots.txt-fil trycker du på "Spara ändringar i robots.txt". Det är allt.

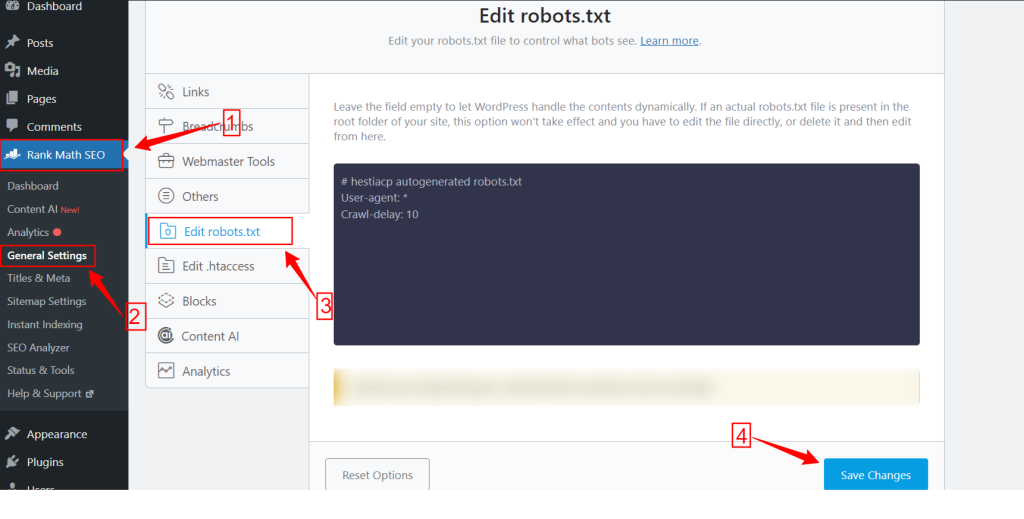

Rank Math:

När du använder Rank Math-plugin, gå till Rank Math-instrumentpanelen i din WordPress-instrumentpanel och klicka Allmänna Inställningar. Välj sedan Redigera robots.txt flik. Gör dina ändringar och redigera på robots.txt-skärmen och tryck på Spara ändringar knappen när du är klar.

OBS: Du måste ta bort standardfilen robots.txt från webbplatsens rotmapp med hjälp av FTP-klienten.

Metod 2: Skapa Robots.txt-fil manuellt med FTP

Den manuella processen att lägga till en robots.txt-fil kräver att du kommer åt WordPress-värden med en FTP-klient som FileZilla, WinSCP och Cyberduck. FTP-inloggningsinformation är tillgänglig i cPanel.

Som du vet måste robots.txt-filen laddas upp till rotmappen på webbplatsen, så du kan inte lägga den i någon underkatalog.

Du kan också skapa en robots.txt-fil i FTP-klienten om det inte finns någon. Från din lokala dator, öppna en enkel textredigerare som Anteckningar och skriv in nedanstående direktiv:

Disallow: /wp-admin/

Tillåt: /wp-admin/admin-ajax.php

Spara den här filen som robots.txt. Nu, i FTP-klienten, leta efter "Filuppladdning” och ladda upp robots.txt-filen till webbplatsens rotmapp.

Nu, för att öppna din nyskapade robots.txt-fil eller föregående, högerklicka på den och välj "Redigera" alternativet. Gör dina ändringar och redigera, tryck sedan på Spara alternativ. Kontrollera nu din robots.txt-fil genom att lägga till robots.txt-filen efter ditt domännamn. Till exempel dindomän.com/robots.txt.

Hur du optimerar din WordPress robots.txt för SEO

Nu när vi vet hur man skapar och redigerar en robots.txt-fil på en WordPress-webbplats, låt oss fokusera på de bästa metoderna för att optimera robots.txt-filen för din WordPress-webbplats.

✅ Skapa en kortfattad fil

Att lägga till en enkel robots.txt-fil hjälper sökrobotens bots att enkelt förstå dina direktiv, så att de förbrukar färre resurser. Dessutom kan du undvika alla oönskade risker som uppstår från konflikter eller fel.

✅ Uteslut WP-kataloger och -filer

Vi bör inte låta vissa filer och kataloger genomsökas av sökrobotarna eftersom dessa områden innehåller viktig och känslig information. När du utesluter dessa länkar från robots.txt-filen kommer sökrobotar inte att besöka dessa områden på din webbplats. Därför kan du säkerställa optimal användning av genomsökningsresurser.

Låt oss lära känna några av WP-katalogerna och filerna:

/wp-admin/ och /wp-includes/: Dessa kataloger kan ge åtkomst till adminområdet och kärnfilerna som får hela WordPress-webbplatsen att fungera, vilket kan vara ett säkerhetshot. Om sökrobotar genomsöker dessa områden kan det vara ett avgörande säkerhetshot. Så vi måste uppgradera Disallow-direktiven.

Disallow: /wp-includes/

Login sida: En annan viktig säkerhetsåtgärd är att avindexera inloggningssidan. Så här slutar du genomsöka:

readme.html: Readme-sidan kan avslöja viktig information som den nuvarande WordPress-versionen av din webbplats för potentiella hackare. Så överväg att avindexera det också.

Tagg- och kategorisidor: Dessa sidor slösar bort genomsökningsbudgetar på grund av deras irrelevans för sökfrågor och förvirrar sökmotorer med duplicerat innehåll.

Disallow: /category/

sökresultat: Orsaken ovan gäller även de interna sökresultatsidorna.

Remisslänkar: Affiliate-program producerar hänvisningslänkar som inte behöver genomsökas också.

✅ Infoga länk till webbplatskarta

I allmänhet skickar WordPress-användare in sin webbplatskarta till kontona i Google Search Console eller Bing Webmaster Tools för att spåra analyser och prestandadata. Men att lägga till en webbplatskarta i robots.txt-filen kan hjälpa sökrobotar att upptäcka innehållet på din webbplats.

Webbplatskarta hjälper din webbplats att indexeras snabbare eftersom sökmotorer enkelt kan navigera i din webbplatsstruktur och -hierarki. Du kan definiera de sidor du vill prioritera för genomsökning. En annan bra sak är att en webbplatskarta kan vägleda sökrobotar till de senaste uppdateringarna på din webbplats.

✅ Effektiv användning av jokertecken

Jokertecken är ditt effektiva vapen för att definiera mönsterbaserade regler som tillåter sökmotorer att blockera eller komma åt en grupp webbadresser eller specifika filtyper. På så sätt behöver du inte begränsa flera sidor separat med mycket tid.

Jokertecken är specialiserade karaktärer som Asterisk (*) och Dollartecken ($). Låt oss beskriva dem:

Asterisk (*): Det vanligaste jokertecken är Asterisk (*), som tillämpar regler brett för en grupp eller specifika mönstermatchade webbadresser eller filtyper.

Ovanstående kod tillåter inte någon sökmotor att genomsöka någon del av webbplatsen.

Dollartecken ($): Detta indikerar slutet på webbadressen, så du kan tillåta eller blockera alla webbadresser som innehåller en specifik term som "pdf”.

Disallow: /*.jpg$

Disallow: /*.docx$

Du kan vara mer strategiskt genom att använda jokertecken. Gilla, du kan blockera eller tillåta:

Specifika kataloger: Blockerar alla webbadresser som börjar med /privat/, inklusive alla filer eller underkataloger i den.

Disallow: /privat/

Webbadresser med specifika parametrar: Blockerar alla webbadresser som innehåller frågeparametern sortering, till exempel /category/?pdf=asc.

Disallow: /*.pdf$

Specifika mönster: Kommer att blockera alla webbadresser som innehåller ordet "checkout", t.ex /product/checkout eller /cart/checkout.

Disallow: /*checkout

Tillåta specifika filer eller kataloger i blockerade kataloger: Blockerar alla webbadresser under /wp-admin/ förutom admin-ajax.php

Disallow: /wp-admin/

Tillåt: /wp-admin/admin-ajax.php

✅ Använd kommentarer

För att förbättra läsbarheten och tydligheten i din robots.txt-fil kan du lägga till kommentarer. Detta görs genom att använda ett hash-tecken (#) i början av raden du vill lägga till som en kommentar.

✅ Övervaka krypningsbeteende

Kontrollera om det finns några problem med genomsökning och indexering efter att du har skickat in robots.txt-filen med hjälp av sökmotorverktyg som Google Search Console eller Bing Webmaster Tools.

✅ Ange regler för sökrobotar

Vissa experter sa också att en effektiv strategi är att skapa olika regler för olika sökmotorrobotar i robots.txt-filer. Att specificera hur varje bot ska komma åt och genomsöka din webbplats hjälper dig att bygga din innehållsstrategi och optimera prestanda.

✅ Överväg mobil- och AMP-versioner

På samma sätt kan du ändra och justera direktiven för din robots.txt-fil för mobil- och AMP-versioner.

✅ Uppdatera din Robots.txt-fil

Men att skapa en robots.txt-fil är din uppgift när du börjar bygga din WordPress-webbplats. Du måste dock ofta leta efter ändringar i din webbplats struktur och uppdateringar av sökmotoralgoritmer så att du kan uppdatera robots.txt-filen.

✅ Gör inte experiment

Filen robots.txt är en del av WordPress-webbplatsens rotkatalog. Därför bör du inte göra några experiment med det. För eventuell förvirring, ta experthjälp eller behåll en enkel robots.txt-fil.

✅ Sista kontroll

Innan du laddar upp eller redigerar robots.txt-filen måste du se till att du har gjort en sista kontroll.

Så här testar du din Robots.txt-fil

Fram till denna punkt har du lärt dig hur du redigerar och optimerar robots.txt-filen på din WordPress-webbplats. Denna kunskap är dock inte komplett utan att förstå hur man testar den. Testning är avgörande för att säkerställa att sökmotorrobotar genomsöker din webbplats korrekt.

En primär metod är att använda testverktyg för robots.txt i Google Search Console. Det här verktyget verifierar om Google genomsöker din webbplats enligt dina angivna direktiv.

Om din webbplats nu läggs till i Google Search Console, logga in på den. Välj din webbplats under "Välj en fastighet". Verktyget börjar hämta din webbplatss robots.txt-fil.

Efter verifiering kommer testverktyget för robots.txt att nämna alla fel och syntaxvarningar. Så du kommer att stå kvar med att fixa dem och skicka in robots.txt-filen igen.

Sammanfatta!

Att förstå och optimera din robots.txt-fil är en avgörande del av teknisk SEO och effektiv webbplatshantering. Vi hoppas denna omfattande guide om hur du optimerar din WordPress robots.txt för SEO.

Nu kan du enkelt konfigurera vilka delar av din webbplats som ska genomsökas av sökmotorer. Sammantaget kommer du att se en förbättring av webbplatsens indexeringseffektivitet och övergripande prestanda.