Plik Robots.txt: co to jest i jak go zoptymalizować pod kątem SEO

Plik robots.txt jest zaimplementowany w Twojej witrynie WordPress, aby sygnalizować wyszukiwarkom, aby indeksowały żądane adresy URL, pliki i typy. Niezależnie od tego, czy jesteś początkującym, czy doświadczonym użytkownikiem WordPressa, zrozumienie celu i prawidłowego użycia pliku robots.txt ma kluczowe znaczenie.

Jeśli możesz powiedzieć Google lub innym wyszukiwarkom, jakie treści mają być indeksowane, może to przyspieszyć indeksowanie najtrafniejszych treści.

W tym poradniku dowiemy się głównie o:

👉 Czym jest plik robots.txt w WordPressie?

👉 Jak stworzyć plik robots.txt w WordPressie?

👉 Jak zoptymalizować plik robots.txt w WordPressie?

👉 Jak przetestować plik robots.txt?

Dzięki temu możesz usprawnić przeszukiwanie i indeksowanie witryny WordPress.

Co to jest plik Robots.txt?

Dodawanie pliku Robots.txt do katalogu głównego witryny WordPress jest powszechną praktyką SEO, która instruuje wyszukiwarki, które strony mają indeksować, a które ignorować. Ogólnie rzecz biorąc, przeglądarki internetowe przeszukują wszystkie publicznie dostępne strony internetowe Twojej witryny w procesie zwanym indeksowaniem.

Kiedy umieścisz plik robots.txt w katalogu głównym witryny WordPress, wyszukiwarki będą szukać wszystkich określonych w nim adresów URL, aby określić, który z nich należy zaindeksować. W tym przypadku jedno powinno być jasne: plik robots.txt nie jest używany do celów indeksowych ani nieindeksowych. Zamiast tego plik robots.txt jedynie pomaga botom wyszukiwarek w indeksowaniu Twoich stron internetowych.

Jak wygląda plik Robots.txt?

Chcemy zobaczyć jak to wygląda, bo dowiedzieliśmy się już o pliku Robots.txt. To prosty plik tekstowy, nie ma znaczenia jak duża jest witryna. Większość właścicieli witryn ustala kilka zasad w oparciu o swoje wymagania.

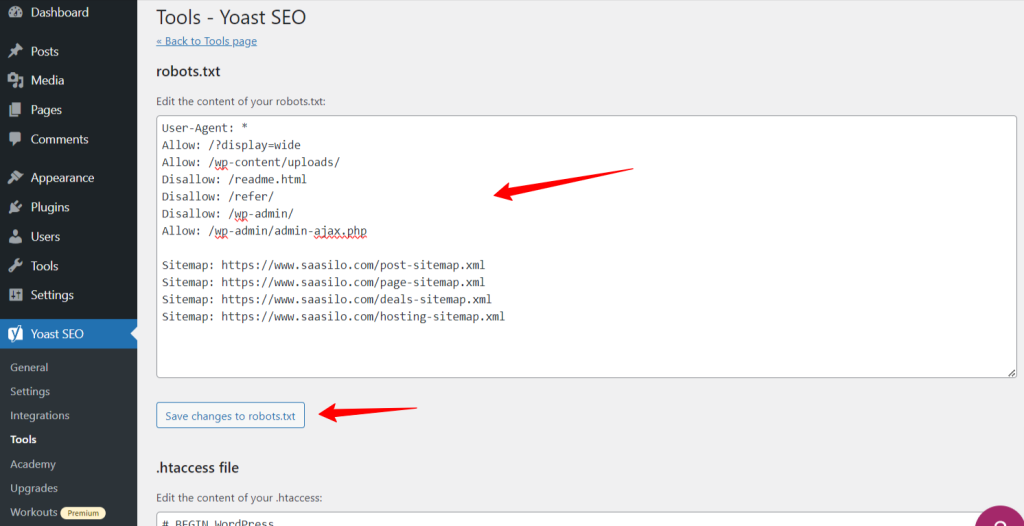

Oto przykład pliku robots.txt:

Zezwalaj na: /?display=wide

Zezwalaj na: /wp-content/uploads/

Nie zezwalaj: /readme.html

Nie zezwalaj: /referuj/

Nie zezwalaj: /wp-admin/

Zezwól na: /wp-admin/admin-ajax.php

Mapa witryny: https://www.saasilo.com/post-sitemap.xml

Mapa witryny: https://www.saasilo.com/page-sitemap.xml

Mapa witryny: https://www.saasilo.com/deals-sitemap.xml

Mapa witryny: https://www.saasilo.com/hosting-sitemap.xml

W powyższym pliku robots.txt różne reguły określają, które adresy URL i roboty indeksujące mogą uzyskać dostęp do witryny internetowej.

Oto podział tego pliku robots.txt:

Agent użytkownika: stosuje następujące reguły do wszystkich robotów indeksujących.

Zezwalaj na: /?display=wide: umożliwia robotom indeksującym dostęp do adresów URL zawierających ?display=wide w ciągu zapytania.

Zezwalaj na: /wp-content/uploads/: Zachęcaj roboty wyszukiwarek do przeszukiwania wszystkich plików i katalogów w /wp-content/uploads/.

Zezwól na: /wp-admin/admin-ajax.php: Umożliwia robotom dostęp do pliku admin-ajax.php w katalogu /wp-admin/.

Nie zezwalaj: /readme.html: Uniemożliwia robotom dostęp do pliku readme.html.

Nie zezwalaj: /referuj/: Blokuje robotom dostęp do katalogu /refer/ i całej jego zawartości.

Nie zezwalaj: /wp-admin/: Uniemożliwia robotom dostęp do katalogu /wp-admin/ i jego zawartości.

Zezwól na: /wp-admin/admin-ajax.php: Umożliwia robotom dostęp do pliku admin-ajax.php w katalogu /wp-admin/.

Mapa witryny: Wreszcie wszystkie adresy URL powiązane z mapą witryny są dostępne do indeksowania przez boty wyszukiwania.

Czy potrzebujesz pliku Robots.txt dla swojej witryny WordPress?

Teraz dowiemy się, jak ważny jest dobrze skonfigurowany plik robots.txt dla naszej witryny WordPress. Oto kilka ważnych ról pliku robots.txt w zarządzaniu i optymalizacji wydajności i widoczności witryny.

➡️ Kontrola nad indeksowaniem: roboty wyszukiwarek są na tyle inteligentne, że rozpoznają wszystkie publiczne strony i treści Twojej witryny. Chcemy jednak zachować prywatność niektórych stron, ponieważ zawierają one pliki administracyjne, takie jak strony wtyczek lub pliki systemowe Twojej witryny WordPress. Użycie pliku robots.txt pomoże Ci zapobiec indeksowaniu tych nieistotnych stron.

➡️ Szybsze indeksowanie dla SEO: Jak już powiedzieliśmy, plik robots.txt nie ułatwia bezpośrednio indeksowania Twoich stron internetowych. Jednak plik robots.txt może nadal przyspieszyć proces indeksowania. Dzieje się tak, ponieważ usuwasz niepotrzebne i nieistotne strony z indeksowania.

➡️ Potrzebujesz mniejszej przepustowości: Roboty wyszukiwarek nie muszą przeglądać całej witryny, gdy dajesz im wskazówki, które obszary należy przeszukać. Zmniejszy to wykorzystanie zasobów serwera i przepustowości. Co również poprawia ogólną wydajność Twojej witryny.

➡️ Problem braku zduplikowanych treści: Jednym z niechcianych, częstych błędów właścicieli witryn jest publikowanie zduplikowanych treści. To zwodzi boty wyszukiwarek o tym, które treści powinny być indeksowane, a które nie. W przeciwnym razie zostaną źle zrozumiane, a oryginalna treść może zostać sklasyfikowana niżej lub ukarana. Dodanie pliku robots.txt może zapobiec indeksowaniu wielu wersji tej samej treści.

➡️ Unikaj niebezpiecznych botów i robotów indeksujących: Możesz łatwo ograniczyć wszelkie roboty spamujące lub boty wyszukujące w pliku robots.txt. Zwiększy to bezpieczeństwo Twojej witryny WordPress. Ponadto możesz także uniemożliwić indeksowanie stron administracyjnych.

Jak utworzyć plik Robots.txt w WordPress?

Teraz, gdy rozumiemy znaczenie dodania pliku robots.txt do naszej witryny WordPress, następnym krokiem jest nauczenie się, jak go utworzyć. Mając to na uwadze, pokażemy Ci dwie metody tworzenia pliku robots.txt w witrynie WordPress.

Metoda 1: Utwórz plik Robots.txt za pomocą wtyczki

Najłatwiejszym sposobem utworzenia i edycji pliku robots.txt jest użycie wtyczki. Przejdź do panelu WordPress i postępuj zgodnie z instrukcjami Wtyczki > Dodaj nowe. Teraz zainstaluj i aktywuj wtyczkę SEO, np Yoast SEO Lub Ranking matematyki.

Zobaczmy ich drogę:

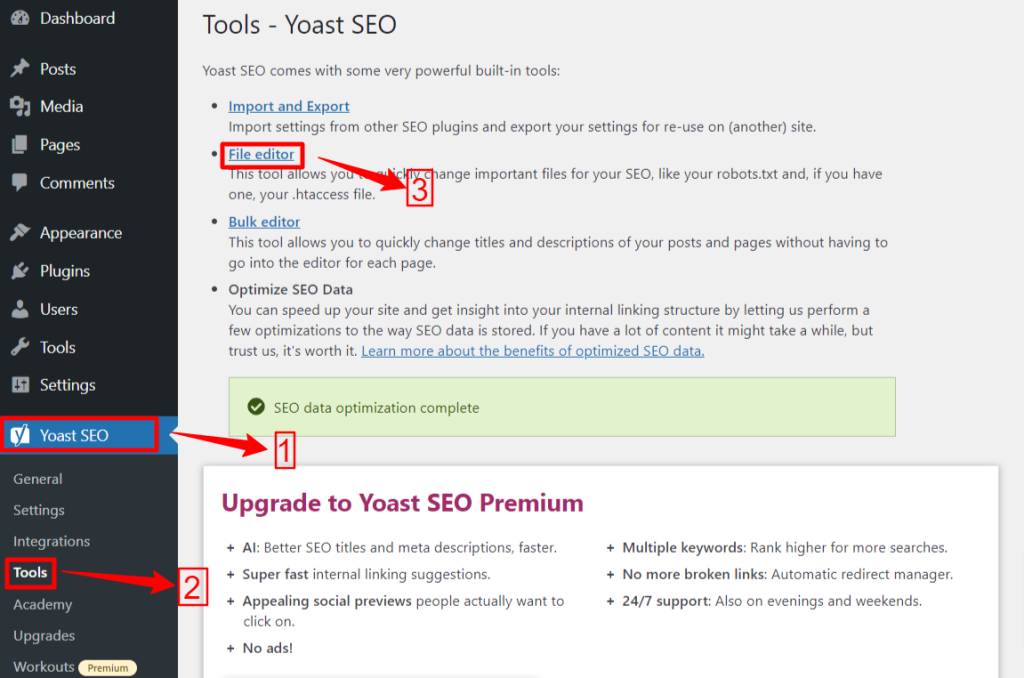

🟢 Yoast SEO:

Jeśli używasz Yoast SEO, z obszaru administracyjnego WP przejdź do Yoast SEO > Narzędzia i kliknij Edytor plików, i wtedy "Utwórz plik Robots.txt” jeśli nie masz żadnego pliku robots.txt. Następnie przejdziesz do ekranu edytora.

Po edycji lub zmianie pliku robots.txt kliknij „Zapisz zmiany w pliku robots.txt”. Otóż to.

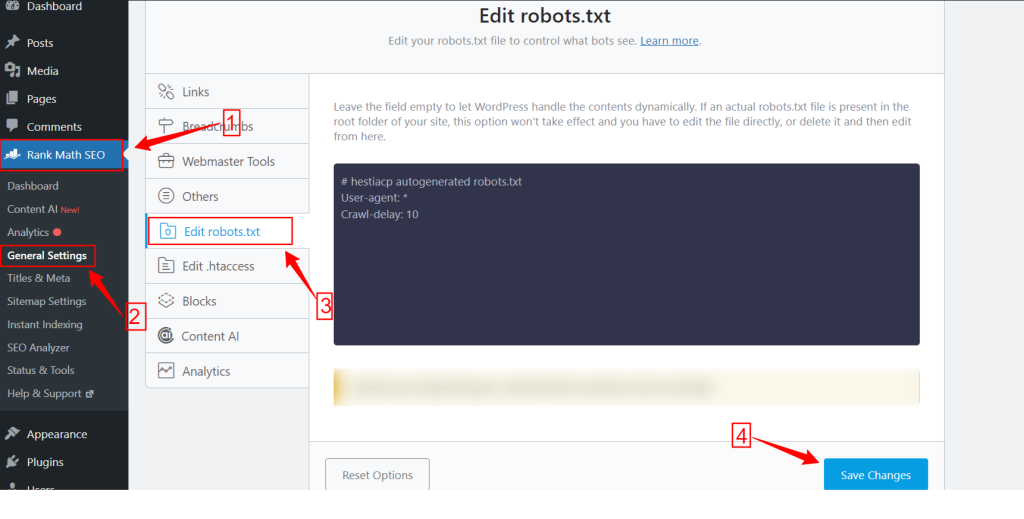

🟢 Matematyka rankingowa:

Korzystając z wtyczki Rank Math, przejdź do panelu Rank Math w panelu WordPress i kliknij Ustawienia główne. Następnie wybierz Edytuj plik robots.txt patka. Wprowadź zmiany i edytuj na ekranie pliku robots.txt, a następnie naciśnij przycisk Zapisz zmiany przycisk po zakończeniu.

Uwaga: Musisz usunąć domyślny plik robots.txt z folderu głównego witryny za pomocą klienta FTP.

Metoda 2: Utwórz ręcznie plik Robots.txt za pomocą protokołu FTP

Ręczny proces dodawania pliku robots.txt wymaga dostępu do hostingu WordPress za pomocą klienta FTP, takiego jak FileZilla, WinSCP i Cyberduck. Dane logowania do FTP dostępne są w cPanelu.

Jak wiadomo, plik robots.txt należy wgrać do folderu głównego serwisu, więc nie można go umieścić w żadnym podkatalogu.

Możesz także utworzyć plik robots.txt w kliencie FTP, jeśli go nie ma. Na komputerze lokalnym otwórz prosty edytor tekstu, taki jak Notatnik, i wprowadź poniższe dyrektywy:

Nie zezwalaj: /wp-admin/

Zezwól na: /wp-admin/admin-ajax.php

Zapisz ten plik jako plik robots.txt. Teraz w kliencie FTP poszukaj „Udostępnianie pliku” i prześlij plik robots.txt do folderu głównego witryny.

Teraz, aby otworzyć nowo utworzony plik robots.txt lub poprzedni, kliknij go prawym przyciskiem myszy i wybierz „Edytować" opcja. Wprowadź zmiany i edytuj, a następnie naciśnij przycisk Ratować opcja. Teraz sprawdź plik robots.txt, dodając plik robots.txt po nazwie domeny. Na przykład twojadomena.com/robots.txt.

Jak zoptymalizować plik robots.txt WordPress pod kątem SEO

Teraz, gdy wiemy, jak utworzyć i edytować plik robots.txt w witrynie WordPress, skupmy się na najlepszych praktykach optymalizacji pliku robots.txt dla Twojej witryny WordPress.

✅ Utwórz zwięzły plik

Dodanie prostego pliku robots.txt ułatwia botom robota zrozumienie Twoich dyrektyw, dzięki czemu zużywają mniej zasobów. Ponadto możesz uniknąć niepożądanego ryzyka wynikającego z konfliktów lub błędów.

✅ Wyklucz katalogi i pliki WP

Nie powinniśmy pozwalać botom wyszukiwania na indeksowanie niektórych plików i katalogów, ponieważ obszary te zawierają istotne i wrażliwe informacje. Jeśli wykluczysz te linki z pliku robots.txt, boty nie będą odwiedzać tych obszarów Twojej witryny. Dzięki temu możesz zapewnić optymalne wykorzystanie zasobów indeksowania.

Poznajmy niektóre katalogi i pliki WP:

/wp-admin/ I /wp-zawiera/: Katalogi te mogą zapewniać dostęp do obszaru administracyjnego i podstawowych plików, dzięki którym cała witryna WordPress działa, co może stanowić zagrożenie dla bezpieczeństwa. Jeśli boty wyszukujące będą indeksować te obszary, może to stanowić kluczowe zagrożenie bezpieczeństwa. Musimy więc zmienić dyrektywy Disallow.

Nie zezwalaj: /wp-includes/

Strona logowania: Innym ważnym środkiem bezpieczeństwa jest deindeksowanie strony logowania. Aby zatrzymać indeksowanie:

readme.html: Strona Readme może ujawnić potencjalnym hakerom kluczowe informacje, takie jak aktualna wersja WordPress Twojej witryny. Dlatego rozważ także jego deindeksację.

Strony tagów i kategorii: Strony te marnują budżety indeksowania ze względu na ich nieistotność dla zapytań wyszukiwania i mylenie wyszukiwarek poprzez powielanie treści.

Nie zezwalaj: /kategoria/

Wyniki wyszukiwania: Powyższy powód dotyczy także wewnętrznych stron wyników wyszukiwania.

Linki polecające: Programy partnerskie generują linki polecające, które również nie muszą być indeksowane.

✅ Wstaw link do mapy witryny

Ogólnie rzecz biorąc, użytkownicy WordPressa przesyłają swoją mapę witryny do kont Google Search Console lub Bing Webmaster Tools w celu śledzenia analiz i danych dotyczących wydajności. Jednak dodanie mapy witryny do pliku robots.txt może pomóc robotom indeksującym w odkryciu zawartości Twojej witryny.

Mapa witryny pomoże szybciej indeksować Twoją witrynę, ponieważ wyszukiwarki mogą z łatwością poruszać się po strukturze i hierarchii witryny. Możesz zdefiniować strony, które mają być priorytetowo indeksowane. Kolejną dobrą rzeczą jest to, że mapa witryny może poprowadzić roboty do najnowszych aktualizacji Twojej witryny.

✅ Efektywne wykorzystanie symboli wieloznacznych

Symbole wieloznaczne to skuteczna broń do definiowania reguł opartych na wzorcach, które umożliwiają wyszukiwarkom blokowanie lub uzyskiwanie dostępu do grupy adresów URL lub określonych typów plików. W ten sposób nie musisz ograniczać kilku stron oddzielnie i zajmować dużo czasu.

Symbole wieloznaczne to znaki specjalne, takie jak Gwiazdka (*) I Znak dolara ($). Opiszmy je:

Gwiazdka (*): Najpopularniejszym symbolem wieloznacznym jest gwiazdka (*), która stosuje reguły w szerokim zakresie dla grupy lub określonych adresów URL lub typów plików dopasowanych do wzorca.

Powyższy kod uniemożliwia wyszukiwarce przeszukiwanie jakiejkolwiek części witryny.

Znak dolara ($): Wskazuje koniec adresu URL, więc możesz zezwolić lub zablokować dowolne adresy URL zawierające określony termin, np. „pdf”.

Nie zezwalaj: /*.jpg$

Nie zezwalaj: /*.docx$

Możesz być bardziej strategiczne dzięki użyciu symboli wieloznacznych. Możesz zablokować lub zezwolić na:

Konkretne katalogi: Zablokuje wszystkie adresy URL zaczynające się od /private/, w tym wszelkie znajdujące się w nich pliki i podkatalogi.

Nie zezwalaj: /prywatny/

Adresy URL z określonymi parametrami: Zablokuje wszystkie adresy URL zawierające sortowanie parametrów zapytania, takie jak /kategoria/?pdf=asc.

Nie zezwalaj: /*.pdf$

Konkretne wzory: Zablokuje wszystkie adresy URL zawierające słowo „checkout”, np /produkt/kasa lub /koszyk/kasa.

Nie zezwalaj: /* do kasy

Zezwalanie na określone pliki lub katalogi w zablokowanych katalogach: Zablokuje wszystkie adresy URL w /wp-admin/ z wyjątkiem admin-ajax.php

Nie zezwalaj: /wp-admin/

Zezwól na: /wp-admin/admin-ajax.php

✅ Użyj komentarzy

Aby zwiększyć czytelność i przejrzystość pliku robots.txt, możesz dodawać komentarze. Odbywa się to poprzez użycie znaku skrótu (#) na początku linii, którą chcesz dodać jako komentarz.

✅ Monitoruj zachowanie podczas indeksowania

Sprawdź, czy po przesłaniu pliku robots.txt za pomocą narzędzi wyszukiwarek, takich jak Google Search Console lub Bing Webmaster Tools, nie występują problemy z przeszukiwaniem i indeksowaniem.

✅ Określ reguły dla botów wyszukiwania

Niektórzy eksperci stwierdzili również, że skuteczną strategią jest tworzenie różnych reguł dla różnych botów wyszukiwarek w plikach robots.txt. Określenie sposobu, w jaki każdy bot będzie uzyskiwał dostęp do Twojej witryny i ją przeszukiwał, pomoże Ci w jej zbudowaniu strategię treści i optymalizację wydajność.

✅ Rozważ wersje mobilne i AMP

Podobnie możesz zmieniać i dostosowywać dyrektywy pliku robots.txt dla wersji mobilnych i AMP.

✅ Zaktualizuj plik Robots.txt

Chociaż utworzenie pliku robots.txt jest Twoim zadaniem, gdy zaczynasz budować witrynę WordPress. Musisz jednak często szukać zmian w strukturze swojej witryny i aktualizacji algorytmu wyszukiwarki, aby móc zaktualizować plik robots.txt.

✅ Nie rób eksperymentów

Plik robots.txt jest częścią katalogu głównego witryny WordPress. Dlatego nie należy przeprowadzać z nim żadnych eksperymentów. W przypadku jakichkolwiek nieporozumień skorzystaj z pomocy eksperta lub zachowaj prosty plik robots.txt.

✅ Kontrola końcowa

Przed przesłaniem lub edycją pliku robots.txt należy upewnić się, że został on ostatecznie sprawdzony.

Jak przetestować plik Robots.txt

Do tego momentu nauczyłeś się edytować i optymalizować plik robots.txt w swojej witrynie WordPress. Jednak wiedza ta nie jest kompletna bez zrozumienia, jak ją przetestować. Testowanie ma kluczowe znaczenie, aby mieć pewność, że boty wyszukiwarek dokładnie indeksują Twoją witrynę.

Jedną z podstawowych metod jest użycie Narzędzie do testowania pliku robots.txt w Google Search Console. To narzędzie sprawdza, czy Google indeksuje Twoją witrynę zgodnie z określonymi dyrektywami.

Teraz, jeśli Twoja witryna jest dodana do Google Search Console, zaloguj się do niej. Wybierz swoją witrynę w sekcji „Wybierz nieruchomość”. Narzędzie rozpocznie pobieranie pliku robots.txt z Twojej witryny.

Po weryfikacji narzędzie do testowania pliku robots.txt wyświetli wszystkie błędy i ostrzeżenia dotyczące składni. Pozostaje więc je naprawić i ponownie przesłać plik robots.txt.

Zakończyć!

Zrozumienie i optymalizacja pliku robots.txt jest kluczową częścią technicznego SEO i skutecznego zarządzania witryną. Mamy nadzieję, że ten kompleksowy przewodnik na temat optymalizacji pliku robots.txt WordPress pod kątem SEO.

Teraz możesz łatwo skonfigurować, które części Twojej witryny mają być indeksowane przez wyszukiwarki. Ogólnie rzecz biorąc, zauważysz poprawę wydajności indeksowania witryny i ogólnej wydajności.