robots.txt ファイルとは何か、SEO 向けに最適化する方法

robots.txt ファイルは、必要な URL、ファイル、およびタイプをクロールするように検索エンジンに指示するために WordPress ウェブサイトに実装されます。初心者でも熟練した WordPress ユーザーでも、robots.txt ファイルの目的と適切な使用方法を理解することは非常に重要です。

Google や他の検索エンジンにクロールするコンテンツを指示できれば、最も関連性の高いコンテンツのインデックス作成を高速化できます。

このガイドでは、主に以下の内容について学習します。

👉 WordPress の robots.txt ファイルとは何ですか?

👉 WordPress で robots.txt ファイルを作成するには?

👉 WordPress で robots.txt ファイルを最適化する方法は?

👉 robots.txt ファイルをテストするには?

これにより、WordPress ウェブサイトのクロールとインデックス作成を改善できます。

Robots.txt ファイルとは何ですか?

WordPress ウェブサイトのルート ディレクトリに Robots.txt ファイルを追加することは、検索エンジンにクロールするページと無視するページを指示する一般的な SEO 手法です。一般に、ウェブ ブラウザは、クロールと呼ばれるプロセスで、ウェブサイトの公開されているすべてのウェブ ページを検索します。

WordPress ウェブサイトのルート ディレクトリに robots.txt ファイルを配置すると、検索エンジンはその中に指定されているすべての URL を検索し、クロールする URL を決定します。ここで、1 つはっきりしていることは、robots.txt ファイルはインデックス目的または非インデックス目的で使用されるわけではないということです。robots.txt ファイルは、検索エンジン ボットが Web ページをクロールするのを支援するだけです。

Robots.txt とはどのようなものですか?

Robots.txt ファイルについてはすでに学習したので、それがどのようなものかを確認したいと思います。これは単純なテキスト ファイルであり、Web サイトの規模は関係ありません。ほとんどの Web サイト所有者は、要件に基づいていくつかのルールを設定します。

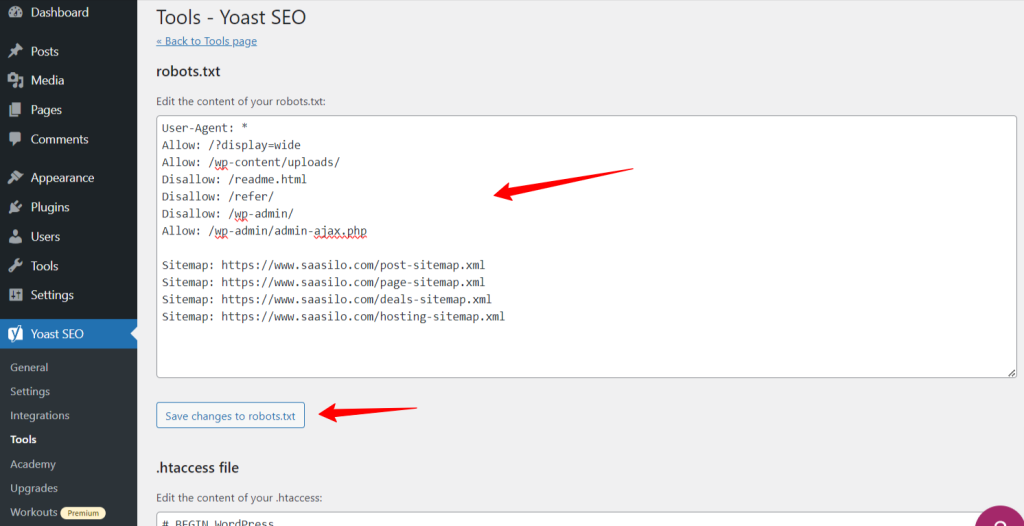

robots.txt ファイルの例を次に示します。

許可: /?display=wide

許可: /wp-content/uploads/

禁止: /readme.html

禁止: /refer/

禁止: /wp-admin/

許可: /wp-admin/admin-ajax.php

サイトマップ: https://www.saasilo.com/post-sitemap.xml

サイトマップ: https://www.saasilo.com/page-sitemap.xml

サイトマップ: https://www.saasilo.com/deals-sitemap.xml

サイトマップ: https://www.saasilo.com/hosting-sitemap.xml

上記の robots.txt ファイルでは、さまざまなルールによって、Web サイト内でアクセスを許可または禁止する URL とファイル クローラーが指定されます。

この robots.txt ファイルの詳細は次のとおりです。

ユーザーエージェント: すべての Web クローラーに次のルールを適用します。

許可: /?display=wide: クローラーがクエリ文字列に ?display=wide を含む URL にアクセスできるようにします。

許可: /wp-content/uploads/: 検索エンジン ボットが /wp-content/uploads/ 内のすべてのファイルとディレクトリをクロールするように促します。

許可: /wp-admin/admin-ajax.php: クローラーが /wp-admin/ ディレクトリ内の admin-ajax.php ファイルにアクセスできるようにします。

禁止: /readme.html: クローラーが readme.html ファイルにアクセスできないようにします。

禁止: /refer/: クローラーが /refer/ ディレクトリとそのすべてのコンテンツにアクセスすることをブロックします。

禁止: /wp-admin/: クローラーが /wp-admin/ ディレクトリとその内容にアクセスできないようにします。

許可: /wp-admin/admin-ajax.php: クローラーが /wp-admin/ ディレクトリ内の admin-ajax.php ファイルにアクセスできるようにします。

サイトマップ最後に、サイトマップにリンクされたすべての URL は、検索ボットによるクロールが可能になります。

WordPress サイトに robots.txt ファイルは必要ですか?

ここで、WordPress ウェブサイトで適切に構成された robots.txt ファイルの重要性について学びます。サイトのパフォーマンスと可視性を管理および最適化するための robots.txt ファイルの重要な役割をいくつか紹介します。

➡️ クローリングの制御: 検索エンジン ボットは、Web サイトの公開ページやコンテンツをすべて把握できるほど賢いです。ただし、WordPress Web サイトのプラグイン ページやシステム ファイルなどの管理ファイルが含まれているページは非公開にしておきたいものです。また、robots.txt ファイルを使用すると、これらの無関係なページのクロールを防ぐことができます。

➡️ SEO のための高速インデックス作成: すでに述べたように、robots.txt ファイルは Web ページのインデックス作成を直接促進するものではありません。ただし、robots.txt ファイルを使用すると、インデックス作成のプロセスを高速化できます。これは、不要なページや無関係なページをクロールから削除することで実現します。

➡️ 帯域幅の節約: 検索エンジン ボットにクロールが必要な領域を指示すると、Web サイト全体をサーフィンする必要がなくなります。これにより、サーバー リソースと帯域幅の使用量が減ります。また、Web サイト全体のパフォーマンスも向上します。

➡️ 重複コンテンツの問題なし: ウェブサイトの所有者が犯す望ましくないよくある失敗の1つは、重複したコンテンツを公開することです。 検索エンジンボットがどのコンテンツをインデックスすべきかを判断するまたは、誤解され、元のコンテンツのランクが下がったり、罰せられたりする可能性があります。robots.txt ファイルを追加すると、同じコンテンツの複数のバージョンがインデックスに登録されないようにすることができます。

➡️ 安全でないボットとクローラーを避ける: robots.txt ファイルで、スパム的なクローラーや検索ボットを簡単に制限できます。これにより、WordPress サイトのセキュリティが強化されます。さらに、管理ページのクロールを禁止することもできます。

WordPress で robots.txt ファイルを作成する方法は?

WordPress ウェブサイトに robots.txt ファイルを追加することの重要性を理解したので、次のステップはそれを作成する方法を学ぶことです。それを念頭に置いて、WordPress ウェブサイトで robots.txt ファイルを作成する 2 つの方法を紹介します。

方法1: プラグインを使用してRobots.txtファイルを作成する

robots.txtファイルを作成および編集する最も簡単な方法は、プラグインを使用することです。WordPressダッシュボードに移動し、 プラグイン > 新規追加. 次に、SEOプラグインをインストールして有効化します。 ヨアストSEO または ランク数学。

彼らのやり方を見てみましょう:

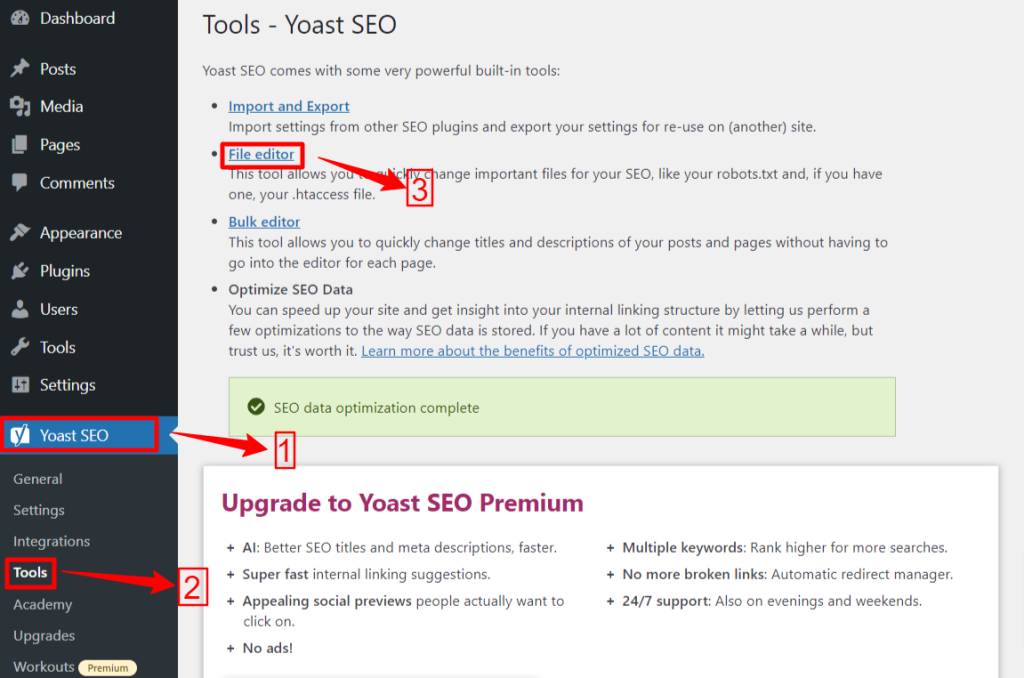

🟢 Yoast SEO:

Yoast SEOを使用している場合は、WP管理画面から Yoast SEO > ツール そしてクリックしてください ファイルエディタ、 その後 "Robots.txt ファイルを作成する” robots.txtファイルがない場合は、次にエディター画面に移動します。

robots.txt ファイルを編集または変更した後、「robots.txt への変更を保存」をクリックします。これで完了です。

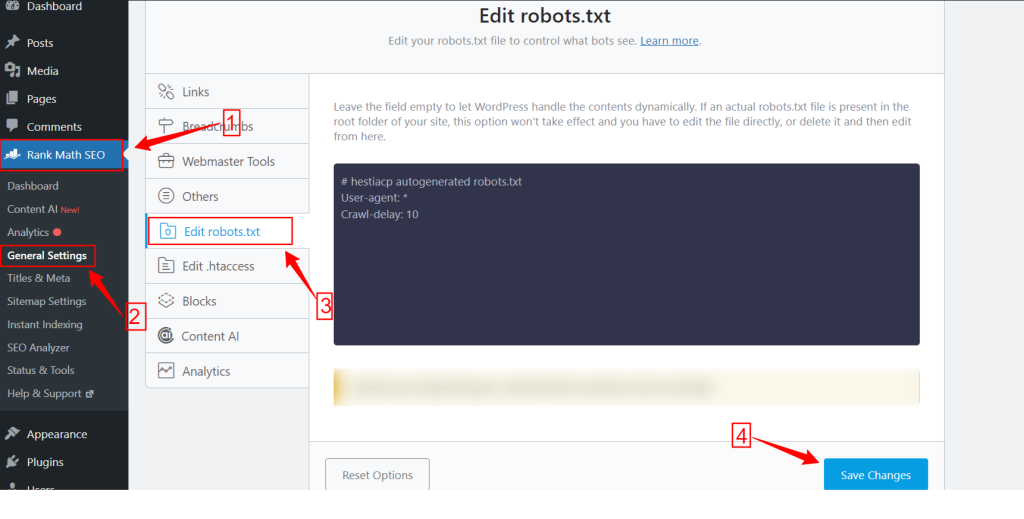

🟢 ランク計算:

Rank Mathプラグインを使用している間、WordPressダッシュボード内のRank Mathダッシュボードに移動し、 一般設定次に、 robots.txtを編集する タブをクリックします。robots.txt画面で変更や編集を行い、 変更内容を保存 完了したらボタンを押します。

注意: FTP クライアントを使用して、Web サイトのルート フォルダーからデフォルトの robots.txt ファイルを削除する必要があります。

方法 2: FTP を使用して Robots.txt ファイルを手動で作成する

robots.txt ファイルを手動で追加するには、FileZilla、WinSCP、Cyberduck などの FTP クライアントを使用して WordPress ホスティングにアクセスする必要があります。FTP ログイン情報は cPanel で入手できます。

ご存知のとおり、robots.txt ファイルは Web サイトのルート フォルダーにアップロードする必要があるため、サブディレクトリに配置することはできません。

FTP クライアントに robots.txt ファイルがない場合、作成することもできます。ローカル コンピューターから、メモ帳などのシンプルなテキスト エディターを開き、以下の指示を入力します。

禁止: /wp-admin/

許可: /wp-admin/admin-ajax.php

このファイルをrobots.txtとして保存します。次に、FTPクライアント内で「ファイルのアップロード” オプションを選択し、robots.txt ファイルを Web サイトのルート フォルダーにアップロードします。

さて、新しく作成したrobots.txtファイルまたは以前のrobots.txtファイルを開くには、それを右クリックして「編集”オプションを選択します。変更と編集を行い、 保存 オプション。次に、ドメイン名の後に robots.txt ファイルを追加して、robots.txt ファイルを確認します。例: yourdomain.com/robots.txt。

WordPress robots.txt を SEO 向けに最適化する方法

WordPress ウェブサイトで robots.txt ファイルを作成および編集する方法がわかったので、WordPress サイトの robots.txt ファイルを最適化するベスト プラクティスに焦点を当てましょう。

✅ 簡潔なファイルを作成する

シンプルな robots.txt ファイルを追加すると、クローラーのボットが指示を簡単に理解できるようになり、消費するリソースが少なくなります。さらに、競合やエラーから生じる望ましくないリスクを回避できます。

✅ WP ディレクトリとファイルを除外する

特定のファイルやディレクトリには重要な機密情報が含まれているため、検索ボットによるクロールを許可しないでください。robots.txt ファイルからこれらのリンクを除外すると、検索ボットは Web サイトのこれらの領域にアクセスしなくなります。そのため、クロール リソースを最適に使用できます。

WP のディレクトリとファイルのいくつかについて見てみましょう。

/wp-admin/ そして /wp-includes/: これらのディレクトリは、WordPress ウェブサイト全体を機能させる管理領域とコア ファイルへのアクセスを許可する可能性があり、セキュリティ上の脅威となる可能性があります。検索ボットがこれらの領域をクロールすると、重大なセキュリティ上の脅威となる可能性があります。そのため、Disallow ディレクティブを強化する必要があります。

禁止: /wp-includes/

ログインページ: もう一つの重要なセキュリティ対策は、ログインページのインデックスを削除することです。クロールを停止するには:

readme.html: Readme ページは、ウェブサイトの現在の WordPress バージョンなどの重要な情報を潜在的なハッカーに公開する可能性があります。そのため、これもインデックス解除することを検討してください。

タグとカテゴリーページこれらのページは検索クエリとの関連性がないためクロール バジェットを無駄にし、重複コンテンツで検索エンジンを混乱させます。

禁止: /category/

の検索結果: 上記の理由は、内部検索結果ページにも当てはまります。

紹介リンク: アフィリエイト プログラムでは、クロールする必要のない紹介リンクも生成されます。

✅ サイトマップリンクを挿入

通常、WordPress ユーザーは、分析とパフォーマンス データを追跡するために、サイトマップを Google Search Console または Bing Webmaster Tools アカウントに送信します。ただし、robots.txt ファイルにサイトマップを追加すると、クローラーが Web サイトのコンテンツを検出しやすくなります。

サイトマップは、検索エンジンがウェブサイトの構造と階層を簡単にナビゲートできるため、ウェブサイトのインデックス作成を高速化するのに役立ちます。クロールの優先順位を付けるページを定義できます。もう 1 つの利点は、サイトマップによってクローラーがウェブサイトの最新の更新に誘導されることです。

✅ ワイルドカードの効果的な使用

ワイルドカードは、検索エンジンが URL のグループまたは特定のファイル タイプをブロックまたはアクセスできるようにするパターン ベースのルールを定義するための効果的な手段です。これにより、多くの時間をかけて複数のページを個別に制限する必要がなくなります。

ワイルドカードは次のような特殊な文字です。 アスタリスク(*) そして ドル記号 ($)それらを説明しましょう:

アスタリスク(*): 最も一般的なワイルドカードはアスタリスク (*) で、グループまたは特定のパターンに一致する URL やファイル タイプに対してルールを広範囲に適用します。

上記のコードは、検索エンジンによる Web サイトのどの部分のクロールも禁止します。

ドル記号($): これはURLの終わりを示すので、「pdf”。

許可しない: /*.jpg$

許可しない: /*.docx$

あなたは ワイルドカードを使用してより戦略的にたとえば、次のものをブロックまたは許可できます:

特定のディレクトリ: /private/ で始まるすべての URL と、その中のすべてのファイルやサブディレクトリをブロックします。

禁止: /private/

特定のパラメータを持つ URL: /category/?pdf=asc など、クエリ パラメータ sort を含むすべての URL をブロックします。

許可しない: /*.pdf$

具体的なパターン: 「チェックアウト」という単語を含むすべてのURLをブロックします。 /product/checkout または /cart/checkout.

禁止: /*チェックアウト

ブロックされたディレクトリ内の特定のファイルまたはディレクトリを許可する: admin-ajax.php を除く /wp-admin/ の下にあるすべての URL をブロックします。

禁止: /wp-admin/

許可: /wp-admin/admin-ajax.php

✅ コメントを使用する

robots.txt ファイルの読みやすさと明確さを高めるために、コメントを追加できます。これは、コメントとして追加する行の先頭にハッシュ (#) 記号を使用して行います。

✅ クローリング動作を監視する

Google Search Console や Bing Webmaster Tools などの検索エンジン ツールを使用して robots.txt ファイルを送信した後、クロールやインデックス作成の問題がないか確認します。

✅ 検索ボットのルールを指定する

専門家の中には、robots.txtファイルで検索エンジンボットごとに異なるルールを作成することが効果的な戦略であると述べた人もいます。各ボットがウェブサイトにアクセスしてクロールする方法を指定すると、 コンテンツ戦略と最適化 パフォーマンス。

✅ モバイル版とAMP版を検討する

同様に、モバイル バージョンと AMP バージョンの robots.txt ファイルのディレクティブを変更および調整することもできます。

✅ Robots.txtファイルを更新する

ただし、WordPress ウェブサイトの構築を開始するときは、robots.txt ファイルを作成する必要があります。ただし、robots.txt ファイルを更新できるように、ウェブサイトの構造の変更や検索エンジン アルゴリズムの更新を頻繁に確認する必要があります。

✅ 実験をしない

robots.txt ファイルは、WordPress ウェブサイトのルート ディレクトリの一部です。したがって、これを使って実験を行うべきではありません。不明な点がある場合は、専門家の助けを借りるか、シンプルな robots.txt ファイルを維持してください。

✅ 最終チェック

robots.txt ファイルをアップロードまたは編集する前に、必ず最終チェックを実施してください。

Robots.txt ファイルをテストする方法

ここまで、WordPress ウェブサイトの robots.txt ファイルを編集して最適化する方法を学びました。ただし、テスト方法を理解しなければ、この知識は完全ではありません。検索エンジン ボットがサイトを正確にクロールしていることを確認するには、テストが不可欠です。

主な方法の1つは、 robots.txt テストツール Google Search Console で。このツールは、指定した指示に従って Google が Web サイトをクロールしているかどうかを確認します。

ウェブサイトが Google Search Console に追加されている場合は、ログインしてください。「プロパティを選択してください」の下でウェブサイトを選択します。ツールはウェブサイトの robots.txt ファイルの取得を開始します。

検証後、robots.txt テスト ツールはすべてのエラーと構文の警告を表示します。そのため、それらを修正して robots.txt ファイルを再度送信することになります。

まとめ!

robots.txt ファイルを理解して最適化することは、技術的な SEO と効果的な Web サイト管理の重要な部分です。この包括的なガイドが、WordPress robots.txt を SEO 用に最適化する方法をご理解いただけることを願っています。

これで、検索エンジンがクロールするウェブサイトの部分を簡単に設定できるようになりました。全体として、サイトのインデックス作成の効率と全体的なパフォーマンスが向上します。