File Robots.txt: cos'è e come ottimizzarlo per la SEO

Il file robots.txt viene implementato sul tuo sito Web WordPress per segnalare ai motori di ricerca di eseguire la scansione degli URL, dei file e dei tipi desiderati. Che tu sia un principiante o un utente esperto di WordPress, comprendere lo scopo e l'utilizzo corretto del file robots.txt è fondamentale.

Se puoi indicare a Google o ad altri motori di ricerca quali contenuti sottoporre a scansione, puoi accelerare l'indicizzazione dei tuoi contenuti più pertinenti.

In questa guida impareremo principalmente:

👉 Cos'è il file robots.txt in WordPress?

👉 Come creare il file robots.txt in WordPress?

👉 Come ottimizzare il file robots.txt in WordPress?

👉 Come testare il file robots.txt?

In questo modo puoi migliorare la scansione e l'indicizzazione del tuo sito Web WordPress.

Cos'è un file Robots.txt?

L'aggiunta di un file Robots.txt alla directory principale del sito Web WordPress è una pratica SEO comune che indica ai motori di ricerca quali pagine scansionare e quali ignorare. In generale, i browser web eseguono ricerche in tutte le pagine web disponibili pubblicamente del tuo sito web in un processo noto come scansione.

Quando inserisci un file robots.txt nella directory principale del tuo sito Web WordPress, i motori di ricerca cercano tutti gli URL specificati al suo interno per determinare quali scansionare. Qui, una cosa dovrebbe essere chiara: il file robots.txt non viene utilizzato per scopi di indicizzazione o non indicizzazione. Piuttosto, il file robots.txt aiuta solo i bot dei motori di ricerca a eseguire la scansione delle tue pagine web.

Che aspetto ha Robots.txt?

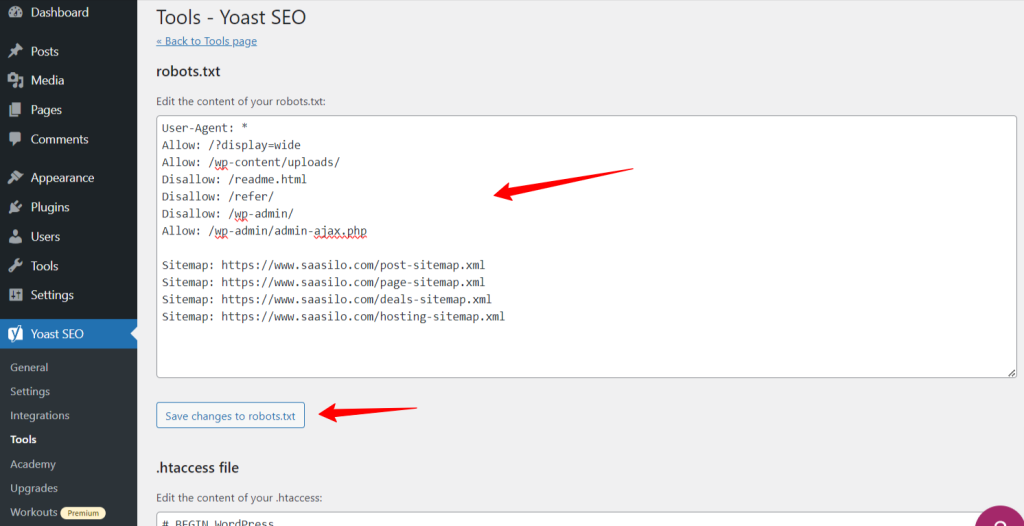

Vogliamo vedere come appare poiché abbiamo già appreso del file Robots.txt. È un semplice file di testo, non importa quanto è grande un sito web. La maggior parte dei proprietari di siti Web stabilisce alcune regole in base alle proprie esigenze.

Ecco un esempio di file robots.txt:

Consenti: /?display=wide

Consenti: /wp-content/uploads/

Non consentire: /readme.html

Non consentire: /refer/

Non consentire: /wp-admin/

Consenti: /wp-admin/admin-ajax.php

Mappa del sito: https://www.saasilo.com/post-sitemap.xml

Mappa del sito: https://www.saasilo.com/page-sitemap.xml

Mappa del sito: https://www.saasilo.com/deals-sitemap.xml

Mappa del sito: https://www.saasilo.com/hosting-sitemap.xml

Nel file robots.txt sopra, varie regole stabiliscono quali URL e crawler di file possono o meno accedere al sito web.

Ecco la ripartizione di questo file robots.txt:

Agente utente: applica le seguenti regole a tutti i web crawler.

Consenti: /?display=wide: consente ai crawler di accedere agli URL con ?display=wide nella stringa di query.

Consenti: /wp-content/uploads/: incoraggia i bot dei motori di ricerca a eseguire la scansione di tutti i file e le directory all'interno di /wp-content/uploads/.

Consenti: /wp-admin/admin-ajax.php: consente ai crawler di accedere al file admin-ajax.php all'interno della directory /wp-admin/.

Non consentire: /readme.html: impedisce ai crawler di accedere al file readme.html.

Non consentire: /refer/: impedisce ai crawler di accedere alla directory /refer/ e a tutti i suoi contenuti.

Non consentire: /wp-admin/: impedisce ai crawler di accedere alla directory /wp-admin/ e ai suoi contenuti.

Consenti: /wp-admin/admin-ajax.php: consente ai crawler di accedere al file admin-ajax.php all'interno della directory /wp-admin/.

Mappa del sito: Infine, tutti gli URL collegati alla mappa del sito sono disponibili per la scansione da parte dei bot di ricerca.

Hai bisogno di un file Robots.txt per il tuo sito WordPress?

Ora impareremo l'importanza di un file robots.txt ben configurato per il nostro sito Web WordPress. Ecco alcuni ruoli importanti del file robots.txt per la gestione e l'ottimizzazione delle prestazioni e della visibilità del tuo sito.

➡️ Controllo sulla scansione: i bot dei motori di ricerca sono abbastanza intelligenti da individuare tutte le pagine o i contenuti pubblici del tuo sito web. Tuttavia, vogliamo mantenere alcune pagine private poiché contengono file amministrativi come le pagine dei plug-in o i file di sistema del tuo sito Web WordPress. Inoltre, l'utilizzo del file robots.txt ti aiuterà a impedire la scansione di queste pagine irrilevanti.

➡️ Indicizzazione più rapida per la SEO: Come abbiamo già detto, il file robots.txt non facilita direttamente l'indicizzazione delle tue pagine web. Tuttavia, il file robots.txt può comunque velocizzare il processo di indicizzazione. Ciò accade perché rimuovi le pagine non necessarie e irrilevanti dalla scansione.

➡️ Hai bisogno di meno larghezza di banda: i bot dei motori di ricerca non hanno bisogno di navigare in tutto il tuo sito web quando fornisci loro indicazioni su quali aree devono essere sottoposte a scansione. Ridurrà l'utilizzo delle risorse del server e della larghezza di banda. Ciò migliora anche le prestazioni complessive del tuo sito web.

➡️ Nessun problema di contenuto duplicato: Un errore comune e indesiderato dei proprietari di siti Web è la pubblicazione di contenuti duplicati. Illude bot dei motori di ricerca su quali contenuti debbano essere indicizzati o meno. Oppure verranno fraintesi e il contenuto originale potrebbe essere classificato più in basso o punito. L'aggiunta di un file robots.txt può garantire che non venga effettuata l'indicizzazione di più versioni dello stesso contenuto.

➡️ Evita bot e crawler insicuri: Puoi limitare facilmente eventuali crawler di spam o robot di ricerca in un file robots.txt. Migliorerà la sicurezza del tuo sito Web WordPress. Inoltre, puoi anche impedire la scansione delle pagine di amministrazione.

Come creare un file Robots.txt in WordPress?

Ora che abbiamo compreso l'importanza di aggiungere un file robots.txt al nostro sito WordPress, il passo successivo è imparare a crearne uno. Con questo in mente, ti mostreremo due metodi su come creare un file robots.txt nel tuo sito web WordPress.

Metodo 1: creare un file Robots.txt utilizzando il plugin

Il modo più semplice per creare e modificare il file robots.txt è utilizzare un plugin. Vai alla dashboard di WordPress e segui Plugin > Aggiungi nuovo. Ora installa e attiva un plugin SEO come Ottimo SEO O Classifica matematica.

Vediamo il loro percorso:

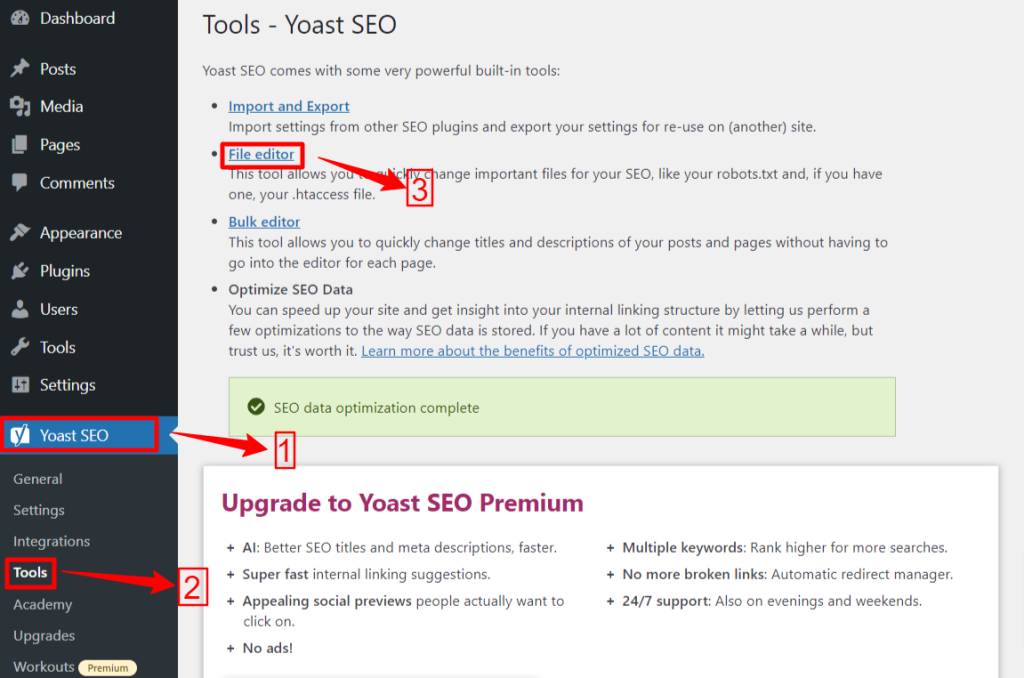

🟢 Yoast SEO:

Se utilizzi Yoast SEO, dall'area di amministrazione del tuo WP vai al file Yoast SEO > Strumenti e fare clic Redattore di file, poi "Crea il file Robots.txt” se non hai alcun file robots.txt. Successivamente, ti sposterai alla schermata dell'editor.

Dopo aver modificato o modificato il file robots.txt, premi "Salva modifiche in robots.txt". Questo è tutto.

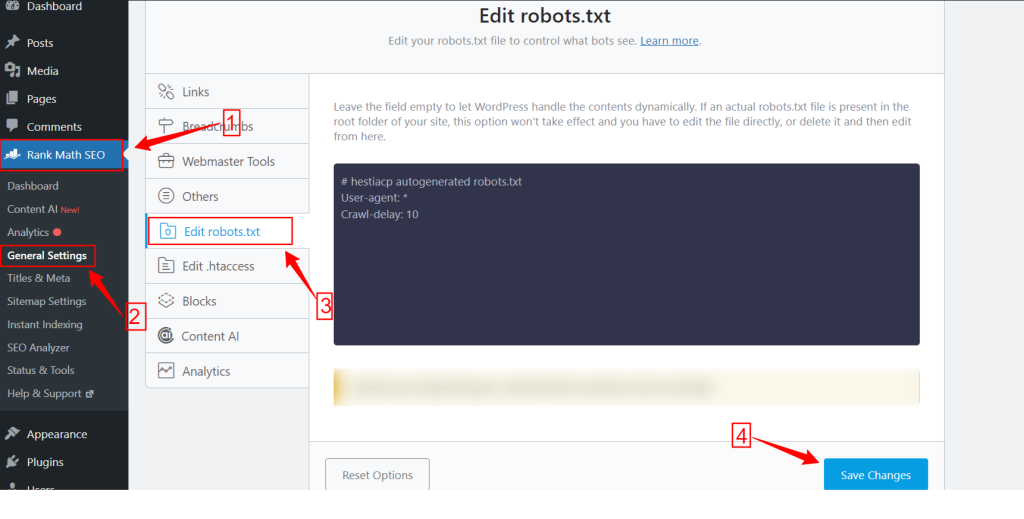

🟢 Classifica matematica:

Mentre utilizzi il plug-in Rank Math, vai alla dashboard Rank Math nella dashboard di WordPress e fai clic su impostazioni generali. Quindi, seleziona il Modifica robots.txt scheda. Apporta le modifiche e modifica nella schermata robots.txt e premi il pulsante Salvare le modifiche pulsante una volta terminato.

NB: È necessario eliminare il file robots.txt predefinito dalla cartella principale del sito Web utilizzando il client FTP.

Metodo 2: creare manualmente il file Robots.txt utilizzando FTP

Il processo manuale di aggiunta di un file robots.txt richiede l'accesso all'hosting WordPress utilizzando un client FTP come FileZilla, WinSCP e Cyberduck. Le informazioni di accesso FTP sono disponibili in cPanel.

Come sai, il file robots.txt deve essere caricato nella cartella principale del sito, quindi non puoi inserirlo in nessuna sottodirectory.

Puoi anche creare un file robots.txt nel client FTP se non ce n'è. Dal tuo computer locale, apri un semplice editor di testo come Blocco note e inserisci le seguenti direttive:

Non consentire: /wp-admin/

Consenti: /wp-admin/admin-ajax.php

Salva questo file come robots.txt. Ora, all'interno del client FTP, cerca il "Upload di file" e carica il file robots.txt nella cartella principale del sito web.

Ora, per aprire il file robots.txt appena creato o quello precedente, fai clic destro su di esso e seleziona "Modificare" opzione. Apporta le modifiche e modifica, quindi premi il pulsante Salva opzione. Ora controlla il tuo file robots.txt aggiungendo il file robots.txt dopo il tuo nome di dominio. Ad esempio, tuodominio.com/robots.txt.

Come ottimizzare il file robots.txt di WordPress per la SEO

Ora che sappiamo come creare e modificare un file robots.txt su un sito WordPress, concentriamoci sulle migliori pratiche per ottimizzare il file robots.txt per il tuo sito WordPress.

✅ Crea un file conciso

L'aggiunta di un semplice file robots.txt aiuta i bot del crawler a comprendere facilmente le tue direttive, in modo da consumare meno risorse. Inoltre, puoi evitare eventuali rischi indesiderati derivanti da conflitti o errori.

✅ Escludi directory e file WP

Non dovremmo lasciare che determinati file e directory vengano scansionati dai robot di ricerca poiché queste aree contengono informazioni essenziali e sensibili. Quando escludi questi collegamenti dal file robots.txt, i robot di ricerca non visiteranno queste aree del tuo sito web. Pertanto, puoi garantire un utilizzo ottimale delle risorse di scansione.

Conosciamo alcune delle directory e dei file WP:

/wp-admin/ E /wp-include/: Queste directory possono dare accesso all’area di amministrazione e ai file principali che fanno funzionare l’intero sito Web WordPress, il che può rappresentare una minaccia per la sicurezza. Se i robot di ricerca scansionano queste aree, può rappresentare una minaccia cruciale per la sicurezza. Quindi, dobbiamo aumentare le direttive Disallow.

Non consentire: /wp-include/

Pagina di login: Un'altra importante misura di sicurezza è deindicizzare la pagina di accesso. Per interrompere la scansione:

leggimi.html: La pagina Leggimi può rivelare informazioni cruciali come l'attuale versione WordPress del tuo sito web a potenziali hacker. Quindi considera anche la deindicizzazione.

Pagine di tag e categorie: queste pagine sprecano budget di scansione a causa della loro irrilevanza per le query di ricerca e confondono i motori di ricerca con contenuti duplicati.

Non consentire: /categoria/

risultati di ricerca: Il motivo di cui sopra si applica anche alle pagine dei risultati di ricerca interni.

Collegamenti di riferimento: I programmi di affiliazione producono anche link di riferimento che non necessitano di essere sottoposti a scansione.

✅ Inserisci il link alla mappa del sito

In genere, gli utenti di WordPress inviano la propria mappa del sito agli account Google Search Console o Bing Webmaster Tools per monitorare analisi e dati sulle prestazioni. Tuttavia, l'aggiunta di una mappa del sito al file robots.txt può aiutare i crawler a scoprire il contenuto del tuo sito web.

La mappa del sito aiuterà il tuo sito web a indicizzarsi più velocemente poiché i motori di ricerca possono navigare facilmente nella struttura e nella gerarchia del tuo sito web. Puoi definire le pagine a cui vuoi dare la priorità per la scansione. Un altro aspetto positivo è che una mappa del sito può guidare i crawler verso gli ultimi aggiornamenti sul tuo sito web.

✅ Uso efficace dei caratteri jolly

I caratteri jolly sono la tua arma efficace per definire regole basate su modelli che consentono ai motori di ricerca di bloccare o accedere a un gruppo di URL o tipi di file specifici. In questo modo non è necessario limitare più pagine separatamente impiegando molto tempo.

I caratteri jolly sono caratteri specializzati come Asterisco (*) E Segno del dollaro ($). Descriviamoli:

Asterisco (*): Il carattere jolly più comune è l'asterisco (*), che applica le regole in generale per un gruppo o URL o tipi di file con corrispondenza di pattern specifici.

Il codice riportato sopra impedisce a qualsiasi motore di ricerca di eseguire la scansione di qualsiasi parte del sito web.

Segno del dollaro ($): Ciò indica la fine dell'URL, quindi puoi consentire o bloccare qualsiasi URL che includa un termine specifico come "PDF”.

Non consentire: /*.jpg$

Non consentire: /*.docx$

Tu puoi essere più strategico utilizzando i caratteri jolly. Ad esempio, puoi bloccare o consentire:

Directory specifiche: Bloccherà qualsiasi URL che inizia con /private/, inclusi eventuali file o sottodirectory al suo interno.

Non consentire: /privato/

URL con parametri specifici: Bloccherà tutti gli URL che contengono l'ordinamento dei parametri di query, come /category/?pdf=asc.

Non consentire: /*.pdf$

Modelli specifici: Bloccherà tutti gli URL che includono la parola "checkout", come /prodotto/checkout o /carrello/checkout.

Non consentire: /*checkout

Consentire file o directory specifici all'interno di directory bloccate: Bloccherà tutti gli URL in /wp-admin/ ad eccezione di admin-ajax.php

Non consentire: /wp-admin/

Consenti: /wp-admin/admin-ajax.php

✅ Usa i commenti

Per migliorare la leggibilità e la chiarezza del tuo file robots.txt puoi aggiungere commenti. Questo viene fatto utilizzando un cancelletto (#) all'inizio della riga che desideri aggiungere come commento.

✅ Monitorare il comportamento di scansione

Controlla se sono presenti problemi di scansione e indicizzazione dopo aver inviato il file robots.txt utilizzando gli strumenti dei motori di ricerca come Google Search Console o Bing Webmaster Tools.

✅ Specifica le regole per i bot di ricerca

Alcuni esperti hanno inoltre affermato che una strategia efficace consiste nel creare regole diverse per i diversi bot dei motori di ricerca nei file robots.txt. Specificare in che modo ciascun bot accederà e scansionerà il tuo sito web ti aiuterà a costruire il tuo strategia dei contenuti e ottimizzazione prestazione.

✅ Prendi in considerazione le versioni mobile e AMP

Allo stesso modo, puoi modificare e adattare le direttive del tuo file robots.txt per le versioni mobili e AMP.

✅ Aggiorna il tuo file Robots.txt

Tuttavia, creare un file robots.txt è il tuo compito quando inizi a creare il tuo sito Web WordPress. Tuttavia, devi cercare frequentemente eventuali modifiche nella struttura del tuo sito web e negli aggiornamenti dell'algoritmo del motore di ricerca in modo da poter aggiornare il file robots.txt.

✅ Non fare esperimenti

Il file robots.txt fa parte della directory principale del sito Web WordPress. Quindi, non dovresti fare alcun esperimento con esso. Per qualsiasi dubbio, chiedi l'aiuto di un esperto o conserva un semplice file robots.txt.

✅ Controllo finale

Prima di caricare o modificare il file robots.txt, devi assicurarti di aver effettuato un controllo finale.

Come testare il file Robots.txt

Fino a questo punto, hai imparato come modificare e ottimizzare il file robots.txt sul tuo sito Web WordPress. Tuttavia, questa conoscenza non è completa senza capire come testarla. I test sono fondamentali per garantire che i bot dei motori di ricerca eseguano la scansione del tuo sito in modo accurato.

Un metodo principale è utilizzare il file strumento di test robots.txt nella Google Search Console. Questo strumento verifica se Google sta eseguendo la scansione del tuo sito web secondo le direttive specificate.

Ora, se il tuo sito web viene aggiunto a Google Search Console, accedi ad esso. Seleziona il tuo sito web sotto “Seleziona una proprietà”. Lo strumento inizierà a recuperare il file robots.txt del tuo sito web.

Dopo la verifica, lo strumento di test robots.txt menzionerà tutti gli errori e gli avvisi di sintassi. Pertanto, dovrai risolverli e inviare nuovamente il file robots.txt.

Incartare!

Comprendere e ottimizzare il file robots.txt è una parte cruciale della SEO tecnica e della gestione efficace del sito web. Ci auguriamo che questa guida completa su come ottimizzare il file robots.txt di WordPress per la SEO.

Ora puoi configurare facilmente quali parti del tuo sito web devono essere scansionate dai motori di ricerca. Nel complesso, noterai un miglioramento nell'efficienza dell'indicizzazione del sito e nelle prestazioni generali.