Robots.txt-Datei: Was ist das und wie optimiert man sie für SEO?

Die robots.txt-Datei wird auf Ihrer WordPress-Website implementiert, um Suchmaschinen zu signalisieren, dass sie die gewünschten URLs, Dateien und Typen crawlen sollen. Unabhängig davon, ob Sie Anfänger oder erfahrener WordPress-Benutzer sind, ist es wichtig, den Zweck und die ordnungsgemäße Verwendung der robots.txt-Datei zu verstehen.

Wenn Sie Google oder anderen Suchmaschinen mitteilen können, welche Inhalte gecrawlt werden sollen, kann dies die Indizierung Ihrer relevantesten Inhalte beschleunigen.

In diesem Handbuch erfahren wir hauptsächlich Folgendes:

👉 Was ist die robots.txt-Datei in WordPress?

👉 Wie erstelle ich eine robots.txt-Datei in WordPress?

👉 Wie optimiert man die robots.txt-Datei in WordPress?

👉 Wie testet man die robots.txt-Datei?

So können Sie das Crawling und die Indizierung Ihrer WordPress-Website verbessern.

Was ist eine Robots.txt-Datei?

Das Hinzufügen einer Robots.txt-Datei zum Stammverzeichnis der WordPress-Website ist eine gängige SEO-Praxis, die Suchmaschinen anweist, welche Seiten gecrawlt und welche ignoriert werden sollen. Im Allgemeinen durchsuchen Webbrowser alle öffentlich verfügbaren Webseiten Ihrer Website in einem als Crawling bezeichneten Prozess.

Wenn Sie eine robots.txt-Datei im Stammverzeichnis Ihrer WordPress-Website platzieren, suchen Suchmaschinen nach allen darin angegebenen URLs, um zu bestimmen, welche gecrawlt werden sollen. Dabei sollte eines klar sein: Die robots.txt-Datei wird nicht für Index- oder Nichtindexzwecke verwendet. Vielmehr hilft die robots.txt-Datei den Suchmaschinen-Bots nur beim Crawlen Ihrer Webseiten.

Wie sieht Robots.txt aus?

Wir möchten sehen, wie es aussieht, da wir bereits etwas über die Robots.txt-Datei gelernt haben. Es ist eine einfache Textdatei, es spielt keine Rolle, wie groß eine Website ist. Die meisten Websitebesitzer legen basierend auf ihren Anforderungen einige Regeln fest.

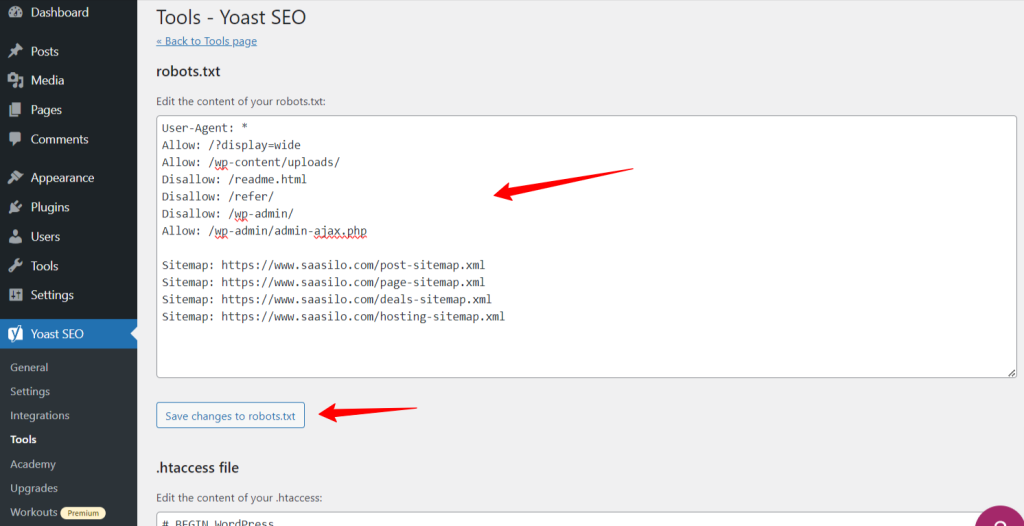

Hier ist ein Beispiel für eine robots.txt-Datei:

Erlauben: /?display=wide

Erlauben: /wp-content/uploads/

Nicht zulassen: /readme.html

Nicht zulassen: /refer/

Nicht zulassen: /wp-admin/

Erlauben: /wp-admin/admin-ajax.php

Sitemap: https://www.saasilo.com/post-sitemap.xml

Sitemap: https://www.saasilo.com/page-sitemap.xml

Sitemap: https://www.saasilo.com/deals-sitemap.xml

Sitemap: https://www.saasilo.com/hosting-sitemap.xml

In der obigen robots.txt-Datei legen verschiedene Regeln fest, auf welche URLs und Dateicrawler innerhalb der Website zugegriffen werden darf oder nicht.

Hier ist die Aufschlüsselung dieser robots.txt-Datei:

User-Agent: Wendet die folgenden Regeln auf alle Webcrawler an.

Erlauben: /?display=wide: Ermöglicht Crawlern den Zugriff auf URLs mit ?display=wide in der Abfragezeichenfolge.

Erlauben: /wp-content/uploads/: Ermutigen Sie Suchmaschinen-Bots, alle Dateien und Verzeichnisse innerhalb von /wp-content/uploads/ zu crawlen.

Erlauben: /wp-admin/admin-ajax.php: Ermöglicht Crawlern den Zugriff auf die Datei admin-ajax.php im Verzeichnis /wp-admin/.

Nicht zulassen: /readme.html: Verhindert, dass Crawler auf die Datei readme.html zugreifen.

Nicht zulassen: /refer/: Blockiert den Zugriff von Crawlern auf das Verzeichnis /refer/ und seinen gesamten Inhalt.

Nicht zulassen: /wp-admin/: Verhindern Sie, dass Crawler auf das Verzeichnis /wp-admin/ und seinen Inhalt zugreifen.

Erlauben: /wp-admin/admin-ajax.php: Ermöglicht Crawlern den Zugriff auf die Datei admin-ajax.php im Verzeichnis /wp-admin/.

Seitenverzeichnis: Schließlich stehen alle mit der Sitemap verknüpften URLs zum Crawlen durch Suchbots zur Verfügung.

Benötigen Sie eine Robots.txt-Datei für Ihre WordPress-Site?

Jetzt erfahren wir, wie wichtig eine gut konfigurierte robots.txt-Datei für unsere WordPress-Website ist. Hier sind einige wichtige Rollen der robots.txt-Datei für die Verwaltung und Optimierung der Leistung und Sichtbarkeit Ihrer Website.

➡️ Kontrolle über das Krabbeln: Suchmaschinen-Bots sind intelligent genug, um alle öffentlichen Seiten oder Inhalte Ihrer Website herauszufinden. Einige Seiten möchten wir jedoch privat halten, da sie Verwaltungsdateien wie die Plugin-Seiten oder Systemdateien Ihrer WordPress-Website enthalten. Und die Verwendung der robots.txt-Datei hilft Ihnen, das Crawlen dieser irrelevanten Seiten zu verhindern.

➡️ Schnellere Indizierung für SEO: Wie bereits erwähnt, erleichtert die robots.txt-Datei die Indizierung Ihrer Webseiten nicht direkt. Sie kann den Indizierungsprozess jedoch beschleunigen. Dies geschieht, weil Sie unnötige und irrelevante Seiten aus dem Crawling entfernen.

➡️ Benötigen Sie weniger Bandbreite: Suchmaschinen-Bots müssen nicht Ihre gesamte Website durchsuchen, wenn Sie ihnen Anweisungen geben, welche Bereiche gecrawlt werden müssen. Dadurch wird die Nutzung von Serverressourcen und Bandbreite verringert. Dies verbessert auch die Gesamtleistung Ihrer Website.

➡️ Kein Problem mit doppeltem Inhalt: Ein unerwünschter häufiger Fehler von Websitebesitzern ist die Veröffentlichung doppelter Inhalte. Es täuscht Suchmaschinen-Bots darüber, welche Inhalte indexiert werden sollen und welche nicht. Oder sie werden missverstanden und der ursprüngliche Inhalt wird möglicherweise niedriger eingestuft oder abgestraft. Durch das Hinzufügen einer robots.txt-Datei können Sie sicherstellen, dass nicht mehrere Versionen desselben Inhalts indexiert werden.

➡️ Vermeiden Sie unsichere Bots und Crawler: Sie können Spam-Crawler oder Suchbots ganz einfach in einer robots.txt-Datei einschränken. Dies erhöht die Sicherheit Ihrer WordPress-Website. Darüber hinaus können Sie das Crawlen der Admin-Seiten untersagen.

Wie erstelle ich eine Robots.txt-Datei in WordPress?

Nachdem wir nun verstanden haben, wie wichtig es ist, unserer WordPress-Website eine robots.txt-Datei hinzuzufügen, lernen wir im nächsten Schritt, wie man eine solche Datei erstellt. Vor diesem Hintergrund zeigen wir Ihnen zwei Methoden zum Erstellen einer robots.txt-Datei auf Ihrer WordPress-Website.

Methode 1: Erstellen Sie eine Robots.txt-Datei mit dem Plugin

Der einfachste Weg, die robots.txt-Datei zu erstellen und zu bearbeiten, ist die Verwendung eines Plugins. Gehen Sie zu Ihrem WordPress-Dashboard und folgen Sie Plugins > Neu hinzufügen. Installieren und aktivieren Sie nun ein SEO-Plugin wie Yoast SEO oder Rang Mathematik.

Schauen wir uns ihren Weg an:

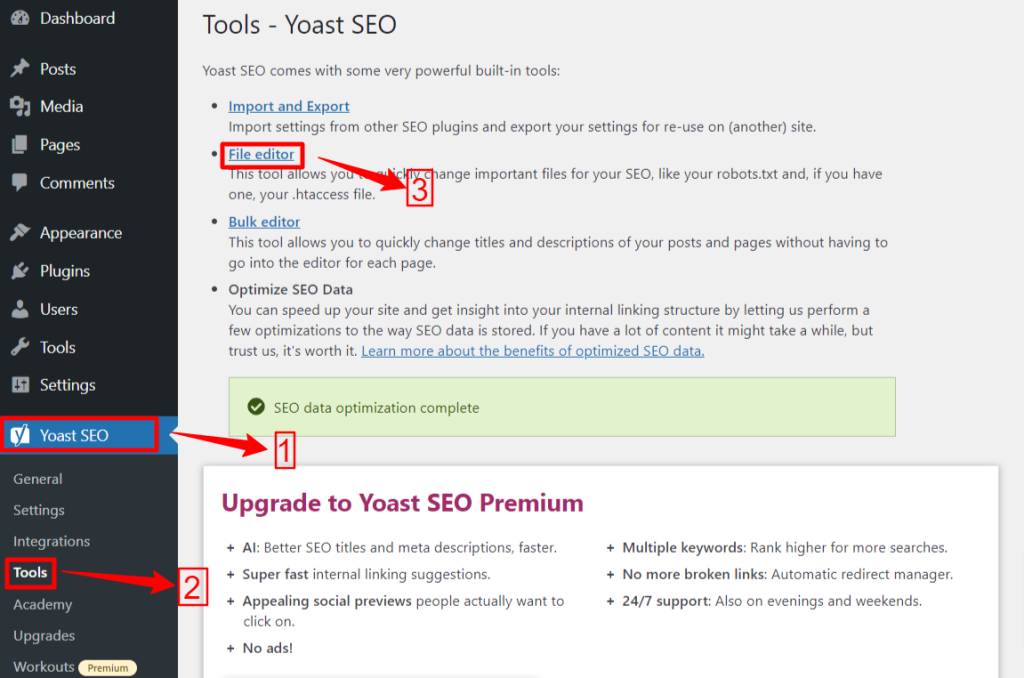

🟢 Yoast SEO:

Wenn Sie Yoast SEO verwenden, navigieren Sie von Ihrem WP-Administrationsbereich zum Yoast SEO > Werkzeuge und klicken Dateieditor, und dann "Robots.txt-Datei erstellen“ wenn Sie keine robots.txt-Datei haben. Als Nächstes gelangen Sie zum Editor-Bildschirm.

Nachdem Sie Ihre robots.txt-Datei bearbeitet oder geändert haben, klicken Sie auf „Änderungen an robots.txt speichern“. Das war‘s.

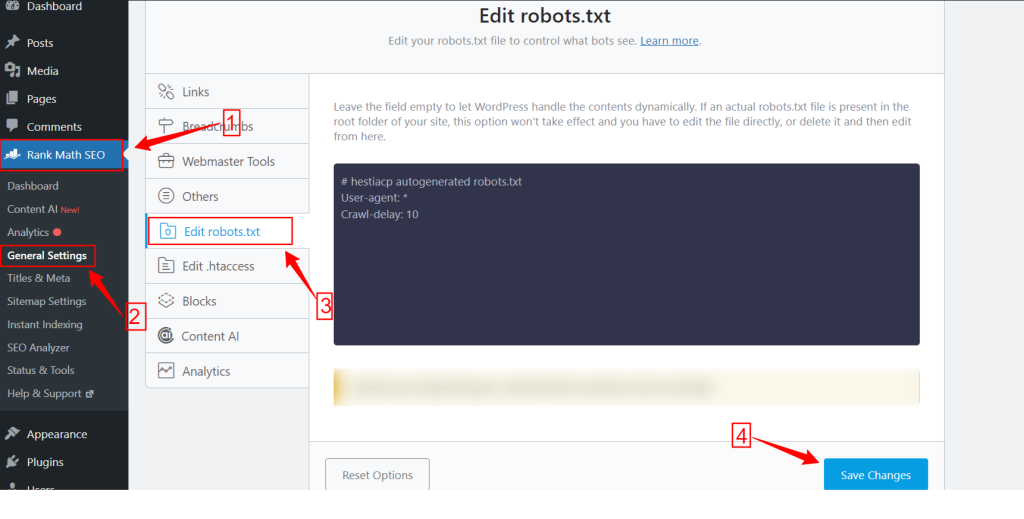

🟢 Rangmathematik:

Gehen Sie bei Verwendung des Rank Math-Plugins zum Rank Math-Dashboard in Ihrem WordPress-Dashboard und klicken Sie auf Allgemeine EinstellungenWählen Sie dann die robots.txt bearbeiten Nehmen Sie Ihre Änderungen vor, bearbeiten Sie die Datei robots.txt und klicken Sie auf Änderungen speichern Schaltfläche, wenn Sie fertig sind.

Hinweis: Sie müssen die Standarddatei „robots.txt“ mithilfe des FTP-Clients aus dem Stammordner der Website löschen.

Methode 2: Manuelles Erstellen der Robots.txt-Datei mithilfe von FTP

Um eine robots.txt-Datei manuell hinzuzufügen, müssen Sie über einen FTP-Client wie FileZilla, WinSCP oder Cyberduck auf das WordPress-Hosting zugreifen. Die FTP-Anmeldeinformationen sind in cPanel verfügbar.

Wie Sie wissen, muss die Datei robots.txt in den Stammordner der Website hochgeladen werden. Sie können sie daher nicht in einem Unterverzeichnis ablegen.

Sie können auch eine robots.txt-Datei im FTP-Client erstellen, falls noch keine vorhanden ist. Öffnen Sie auf Ihrem lokalen Computer einen einfachen Texteditor wie Notepad und geben Sie die folgenden Anweisungen ein:

Nicht zulassen: /wp-admin/

Erlauben: /wp-admin/admin-ajax.php

Speichern Sie diese Datei als robots.txt. Suchen Sie nun im FTP-Client nach „Datei-Upload“ und laden Sie die Datei robots.txt in den Stammordner der Website hoch.

Um nun Ihre neu erstellte robots.txt-Datei oder die vorherige zu öffnen, klicken Sie mit der rechten Maustaste darauf und wählen Sie „Bearbeiten” Option. Nehmen Sie Ihre Änderungen vor und bearbeiten Sie sie. Klicken Sie dann auf Speichern Option. Überprüfen Sie nun Ihre robots.txt-Datei, indem Sie die robots.txt-Datei nach Ihrem Domänennamen hinzufügen. Zum Beispiel yourdomain.com/robots.txt.

So optimieren Sie Ihre WordPress robots.txt für SEO

Nachdem wir nun wissen, wie man eine robots.txt-Datei auf einer WordPress-Website erstellt und bearbeitet, konzentrieren wir uns auf die Best Practices zur Optimierung der robots.txt-Datei für Ihre WordPress-Site.

✅ Erstellen Sie eine prägnante Datei

Durch das Hinzufügen einer einfachen robots.txt-Datei können die Bots des Crawlers Ihre Anweisungen leichter verstehen und verbrauchen so weniger Ressourcen. Außerdem können Sie unerwünschte Risiken vermeiden, die durch Konflikte oder Fehler entstehen.

✅ WP-Verzeichnisse und -Dateien ausschließen

Wir sollten bestimmte Dateien und Verzeichnisse nicht von den Suchbots crawlen lassen, da diese Bereiche wichtige und vertrauliche Informationen enthalten. Wenn Sie diese Links aus der robots.txt-Datei ausschließen, besuchen Suchbots diese Bereiche Ihrer Website nicht. So können Sie eine optimale Nutzung der Crawl-Ressourcen sicherstellen.

Lernen wir einige der WP-Verzeichnisse und -Dateien kennen:

/wp-Administrator/ Und /wp-beinhaltet/: Diese Verzeichnisse können Zugriff auf den Admin-Bereich und die Kerndateien gewähren, die die gesamte WordPress-Website zum Laufen bringen, was ein Sicherheitsrisiko darstellen kann. Wenn Suchbots diese Bereiche crawlen, kann dies ein entscheidendes Sicherheitsrisiko darstellen. Daher müssen wir Disallow-Anweisungen einrichten.

Nicht zulassen: /wp-includes/

Loginseite: Eine weitere wichtige Sicherheitsmaßnahme ist die Deindexierung der Anmeldeseite. So stoppen Sie das Crawling:

readme.html: Die Readme-Seite kann potenziellen Hackern wichtige Informationen wie die aktuelle WordPress-Version Ihrer Website offenbaren. Erwägen Sie daher, auch diese Seite zu deindexieren.

Tag- und Kategorieseiten: Diese Seiten verschwenden Crawl-Budgets aufgrund ihrer Irrelevanz für Suchanfragen und verwirren Suchmaschinen mit doppelten Inhalten.

Nicht zulassen: /Kategorie/

Suchergebnisse: Der oben genannte Grund gilt auch für die internen Suchergebnisseiten.

Empfehlungslinks: Partnerprogramme erstellen Empfehlungslinks, die nicht zusätzlich gecrawlt werden müssen.

✅ Sitemap-Link einfügen

Im Allgemeinen übermitteln WordPress-Benutzer ihre Sitemap an die Google Search Console oder Bing Webmaster Tools-Konten, um Analyse- und Leistungsdaten zu verfolgen. Das Hinzufügen einer Sitemap zur robots.txt-Datei kann Crawlern jedoch dabei helfen, den Inhalt Ihrer Website zu entdecken.

Mithilfe einer Sitemap wird Ihre Website schneller indexiert, da Suchmaschinen die Struktur und Hierarchie Ihrer Website leichter navigieren können. Sie können die Seiten definieren, die Sie beim Crawlen priorisieren möchten. Ein weiterer Vorteil ist, dass eine Sitemap Crawler zu den neuesten Updates auf Ihrer Website führen kann.

✅ Effektive Verwendung von Platzhaltern

Wildcards sind Ihre wirkungsvolle Waffe, um musterbasierte Regeln zu definieren, die es Suchmaschinen ermöglichen, eine Gruppe von URLs oder bestimmte Dateitypen zu blockieren oder darauf zuzugreifen. Auf diese Weise müssen Sie nicht mehrere Seiten einzeln und mit großem Zeitaufwand einschränken.

Platzhalter sind spezielle Zeichen wie Sternchen (*) Und Dollarzeichen ($). Beschreiben wir sie:

Sternchen (*): Das am häufigsten verwendete Platzhalterzeichen ist das Sternchen (*), das Regeln allgemein für eine Gruppe oder bestimmte, mit Mustern übereinstimmende URLs oder Dateitypen anwendet.

Der obige Code untersagt es Suchmaschinen, Teile der Website zu crawlen.

Dollarzeichen ($): Dies gibt das Ende der URL an, sodass Sie alle URLs zulassen oder blockieren können, die einen bestimmten Begriff enthalten, wie „pdf“.

Nicht zulassen: /*.jpg$

Nicht zulassen: /*.docx$

Du kannst sein strategischer durch die Verwendung von Platzhaltern. Sie können beispielsweise Folgendes blockieren oder zulassen:

Bestimmte Verzeichnisse: Blockiert alle URLs, die mit /private/ beginnen, einschließlich aller darin enthaltenen Dateien oder Unterverzeichnisse.

Nicht zulassen: /privat/

URLs mit bestimmten Parametern: Blockiert alle URLs, die den Abfrageparameter „sort“ enthalten, beispielsweise /category/?pdf=asc.

Nicht zulassen: /*.pdf$

Spezifische Muster: Blockiert alle URLs, die das Wort „Checkout“ enthalten, wie zum Beispiel /product/checkout oder /cart/checkout.

Nicht zulassen: /*checkout

Zulassen bestimmter Dateien oder Verzeichnisse innerhalb blockierter Verzeichnisse: Blockiert alle URLs unter /wp-admin/ außer admin-ajax.php

Nicht zulassen: /wp-admin/

Erlauben: /wp-admin/admin-ajax.php

✅ Kommentare verwenden

Um die Lesbarkeit und Übersichtlichkeit Ihrer robots.txt-Datei zu verbessern, können Sie Kommentare hinzufügen. Dies geschieht durch die Verwendung eines Rautezeichens (#) am Anfang der Zeile, die Sie als Kommentar hinzufügen möchten.

✅ Überwachen Sie das Crawling-Verhalten

Überprüfen Sie mit Suchmaschinentools wie der Google Search Console oder den Bing Webmaster Tools, ob es nach dem Senden der robots.txt-Datei Probleme beim Crawling und der Indizierung gibt.

✅ Regeln für Suchbots festlegen

Einige Experten gaben auch an, dass eine effektive Strategie darin besteht, unterschiedliche Regeln für verschiedene Suchmaschinen-Bots in robots.txt-Dateien zu erstellen. Wenn Sie angeben, wie jeder Bot auf Ihre Website zugreift und sie crawlt, können Sie Ihre Content-Strategie und Optimierung Leistung.

✅ Erwägen Sie mobile und AMP-Versionen

Ebenso können Sie die Anweisungen Ihrer robots.txt-Datei für mobile und AMP-Versionen ändern und anpassen.

✅ Aktualisieren Sie Ihre Robots.txt-Datei

Das Erstellen einer robots.txt-Datei ist zwar Ihre Aufgabe, wenn Sie mit dem Aufbau Ihrer WordPress-Website beginnen. Sie müssen jedoch regelmäßig nach Änderungen in der Struktur Ihrer Website und Aktualisierungen des Suchmaschinenalgorithmus suchen, damit Sie die robots.txt-Datei aktualisieren können.

✅ Machen Sie keine Experimente

Die robots.txt-Datei ist Teil des Stammverzeichnisses der WordPress-Website. Daher sollten Sie damit keine Experimente machen. Bei Unklarheiten holen Sie sich die Hilfe eines Experten oder erstellen Sie eine einfache robots.txt-Datei.

✅ Letzter Check

Bevor Sie die robots.txt-Datei hochladen oder bearbeiten, müssen Sie sicherstellen, dass Sie eine letzte Prüfung durchgeführt haben.

So testen Sie Ihre Robots.txt-Datei

Bis zu diesem Punkt haben Sie gelernt, wie Sie die robots.txt-Datei auf Ihrer WordPress-Website bearbeiten und optimieren. Dieses Wissen ist jedoch unvollständig, wenn Sie nicht wissen, wie Sie die Datei testen. Tests sind entscheidend, um sicherzustellen, dass die Suchmaschinen-Bots Ihre Website korrekt crawlen.

Eine primäre Methode ist die Verwendung der robots.txt-Testtool in der Google Search Console. Dieses Tool überprüft, ob Google Ihre Website gemäß den von Ihnen angegebenen Anweisungen crawlt.

Wenn Ihre Website nun zur Google Search Console hinzugefügt wurde, melden Sie sich dort an. Wählen Sie Ihre Website unter „Bitte wählen Sie eine Eigenschaft aus“ aus. Das Tool beginnt mit dem Abrufen der robots.txt-Datei Ihrer Website.

Nach der Überprüfung weist das robots.txt-Testtool auf alle Fehler und Syntaxwarnungen hin. Sie müssen diese also nur noch beheben und die robots.txt-Datei erneut übermitteln.

Einpacken!

Das Verstehen und Optimieren Ihrer robots.txt-Datei ist ein entscheidender Teil der technischen SEO und der effektiven Websiteverwaltung. Wir hoffen, dass dieser umfassende Leitfaden Ihnen hilft, Ihre WordPress-robots.txt für SEO zu optimieren.

Jetzt können Sie ganz einfach konfigurieren, welche Teile Ihrer Website von Suchmaschinen gecrawlt werden sollen. Insgesamt werden Sie eine Verbesserung der Indexierungseffizienz und der Gesamtleistung der Site feststellen.